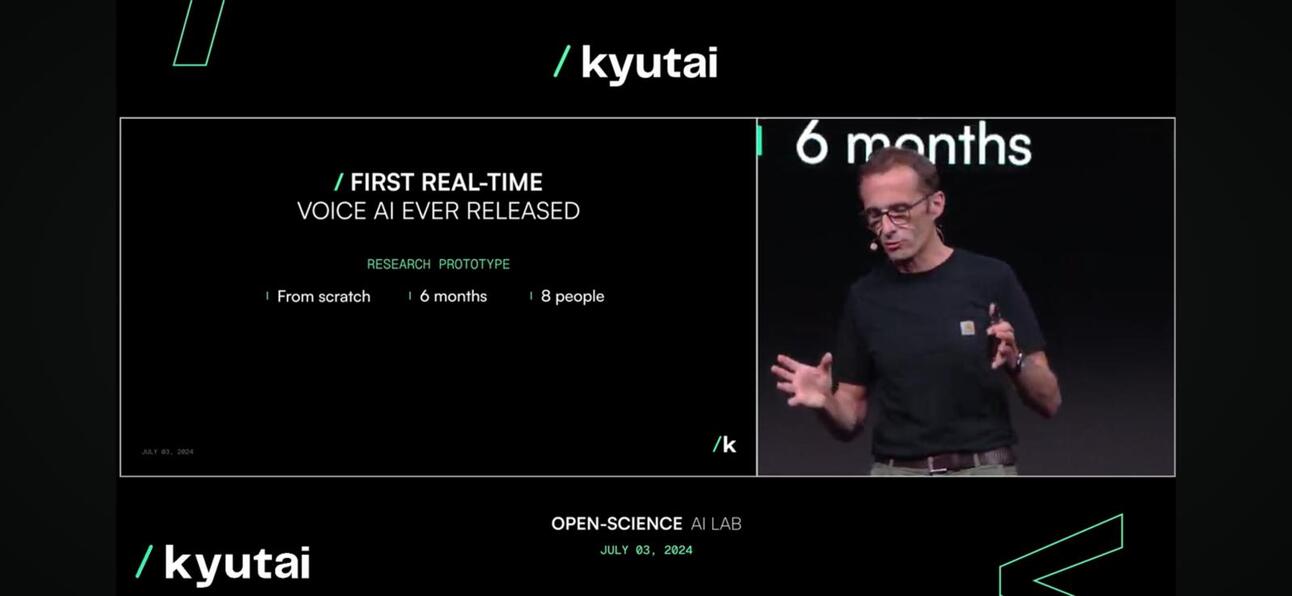

圭太 昨日,百度发布了能听能说的实时开源原生多模态基础模型Moshi,在演示会和线上引起了热烈的反响。

为何这么令人兴奋?

Moshi 能够理解和表达情感,输入和输出时使用不同的口音。它还可以聆听和生成音频和语音,同时保持文本思维的流畅。Moshi 还可以同时处理两个音频流,这样它就可以同时聆听和说话。

非常接近人类(或天网)。

这有什么新奇的呢?

- 对话质量. 语音对话(例如电话)中,声调占 70%,而单词占剩余的 30%。Kyutai 团队引入了一个 音频语言模型 将音频转换成“伪词”,并根据前一个音频预测下一个音频片段,以进行自然对话,从而改善语音对话的 70%。

- 对话延迟。我们可以容忍的最大延迟是 150 毫秒左右,以便进行自然对话。作为第一个版本,Moshi 模型可以提供 160 毫秒到 200 毫秒之间的延迟。并不完美,但考虑到 GPT4o 大约 232 至 320 毫秒, 这是非常了不起的,特别是考虑到他们的团队规模很小,只有 8 名全职员工。

Moshi,实时运行

Moshi,实时运行 - 可访问性。 该模型可以在笔记本电脑或手机等设备上运行,这使得消费者更容易使用。

模型压缩以使其在边缘可用

模型压缩以使其在边缘可用

所以呢?

- 对于企业主或企业客户互动是任何企业的核心。由于大多数企业都在制定 AI 战略,利用 LLM 改善聊天中的客户体验是其中的关键部分,尽管是基于文本的。该战略的下一阶段是改善语音层面的客户体验,即所谓的多模态模型,这即将到来。

- 对于初创公司,包装闭源或开源 LLM 已不再适用。如何将语音提示嵌入到您的应用中?Perplexity 现在正在推出语音提示的付费功能。目前还不是很好,但它正在流行。

- 这对亚洲来说如何? 亚洲,尤其是东南亚,是一个非同质市场,语言和当地对话差异是业务扩展的关键挑战。LLM 和语音模型是解决这一挑战的好方法,可帮助个人和企业驾驭该地区。手机制造商,尤其是中国手机制造商,正在采取措施应对这一挑战和机遇。

他们是怎么做到的?

Kyutai 开发了 Helium,这是一个拥有 70 亿个参数的语言模型,并使用来自该语言模型的合成文本和音频数据对 Moshi 进行了预训练。深入研究后发现,Moshi 的微调涉及使用文本转语音 (TTS) 技术转换的 100,000 个合成转换,其语音是使用另一个 TTS 模型生成的合成数据进行训练的。

Kyutai 的下一步计划是什么?

我们可以期待一份技术报告和开放模型版本;未来的迭代将根据用户反馈进行改进,并采用超级自由和宽松的许可策略来鼓励采用。

如需观看完整主题演讲,请点击 这里.

最后,警惕东方; 豆包 拥有最丰富视频和音频内容的字节跳动模式将成为该领域最强大的参与者。

订阅以获取最新博客文章更新

留下你的评论: