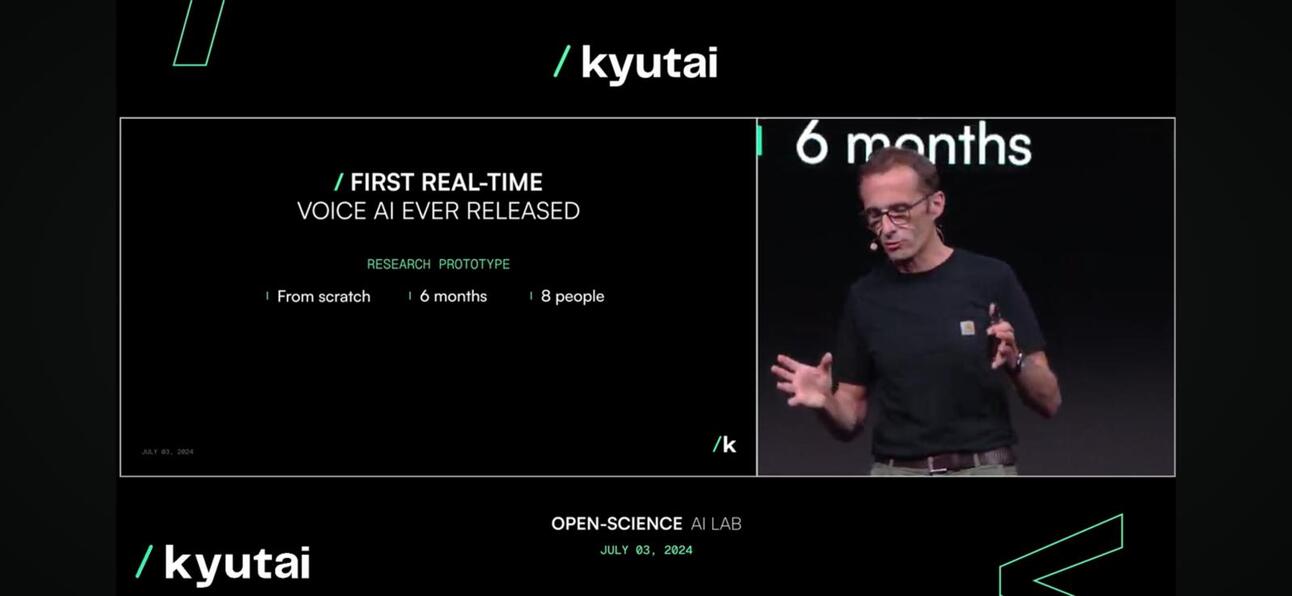

Kyutai revelou ontem o Moshi, um modelo de fundação multimodal nativo de código aberto em tempo real que pode ouvir e falar, causando um alvoroço animado na apresentação e online.

Por que é tão emocionante?

Moshi é capaz de entender e expressar emoções, com diferentes sotaques para entrada e saída. Ele também pode ouvir e gerar áudio e fala enquanto mantém um fluxo de pensamentos textuais. Moshi também pode lidar com dois fluxos de áudio ao mesmo tempo, permitindo que ele ouça e fale ao mesmo tempo.

Muito mais próximo de um ser humano (ou Skynet).

O que há de tão novo nisso?

- Qualidade da conversa. O tom de voz é responsável por 70% das conversas de voz, por exemplo, chamadas telefônicas, enquanto as palavras são responsáveis pelos 30% restantes. A equipe de Kyutai introduziu um modelo de linguagem de áudio que converte áudio em “pseudopalavras” e prevê o próximo segmento de áudio a partir do áudio anterior para transportar uma conversa natural para melhorar 70% de conversas de voz.

- Latência de conversação. A latência máxima que podemos tolerar para ter uma conversa natural é de cerca de 150 milissegundos. Como o primeiro lançamento, o modelo Moshi pode fornecer uma latência entre 160 ms e 200 ms. Não é perfeito, mas considerando que o GPT4o está em torno de 232 a 320 ms, é bastante notável, especialmente considerando que são uma equipe pequena, com 8 ETP.

Moshi, correndo em tempo real

Moshi, correndo em tempo real - Acessibilidade. O modelo pode ser executado em um dispositivo como um laptop ou um celular, o que o torna muito mais acessível aos consumidores.

compressão do modelo para torná-lo disponível na borda

compressão do modelo para torná-lo disponível na borda

E daí?

- Para um empresário ou empresa, as interações com o cliente são a peça central de qualquer negócio. Como a maioria das empresas está desenvolvendo sua estratégia de IA, alavancar um LLM para melhorar a experiência do cliente por chat é uma parte fundamental dela, ainda que baseada em texto. A próxima fase dessa estratégia é melhorar a experiência do cliente no nível de voz, ou o que é conhecido como modelo multimodal, que está bem no horizonte.

- Para uma startup, envolver um LLM de código fechado ou aberto não vai mais funcionar. Como você incorpora um prompt de voz em seu aplicativo? A Perplexity está introduzindo um recurso pago para prompts baseados em voz agora. Ainda não é ótimo, mas é tendência.

- Como isso é importante para a Ásia?? A Ásia, especialmente o Sudeste Asiático, é um mercado não homogêneo, e as diferenças de idioma e diálogo local são desafios-chave para a expansão dos negócios. O modelo LLM e Voice é uma ótima maneira de resolver esse desafio, ajudando indivíduos e empresas a navegar na região. Os fabricantes de telefones, especialmente os chineses, estão tomando medidas para enfrentar esse desafio e oportunidade.

Como eles fizeram isso?

Kyutai desenvolveu o Helium, um modelo de linguagem de 7 bilhões de parâmetros, e pré-treinou Moshi com uma combinação de texto sintético e dados de áudio do referido modelo de linguagem. Indo um pouco mais a fundo, o ajuste fino de Moshi envolveu 100.000 conversões sintéticas convertidas com tecnologia Text-to-Speech (TTS), e sua voz foi treinada em dados sintéticos gerados por outro modelo TTS.

O que vem a seguir para Kyutai?

Podemos esperar um relatório técnico e versões de modelo aberto; iterações futuras serão refinadas com base no feedback do usuário com uma estratégia de licenciamento super liberal e permissiva para incentivar a adoção.

Para assistir à palestra completa, clique em aqui.

Por fim, fique atento ao Leste; o Doubao O modelo da Bytedance, que tem o conteúdo de vídeo e áudio mais rico, será o player mais formidável nesse espaço.

Inscreva-se para receber atualizações sobre as últimas postagens do blog

Deixe seu comentário: