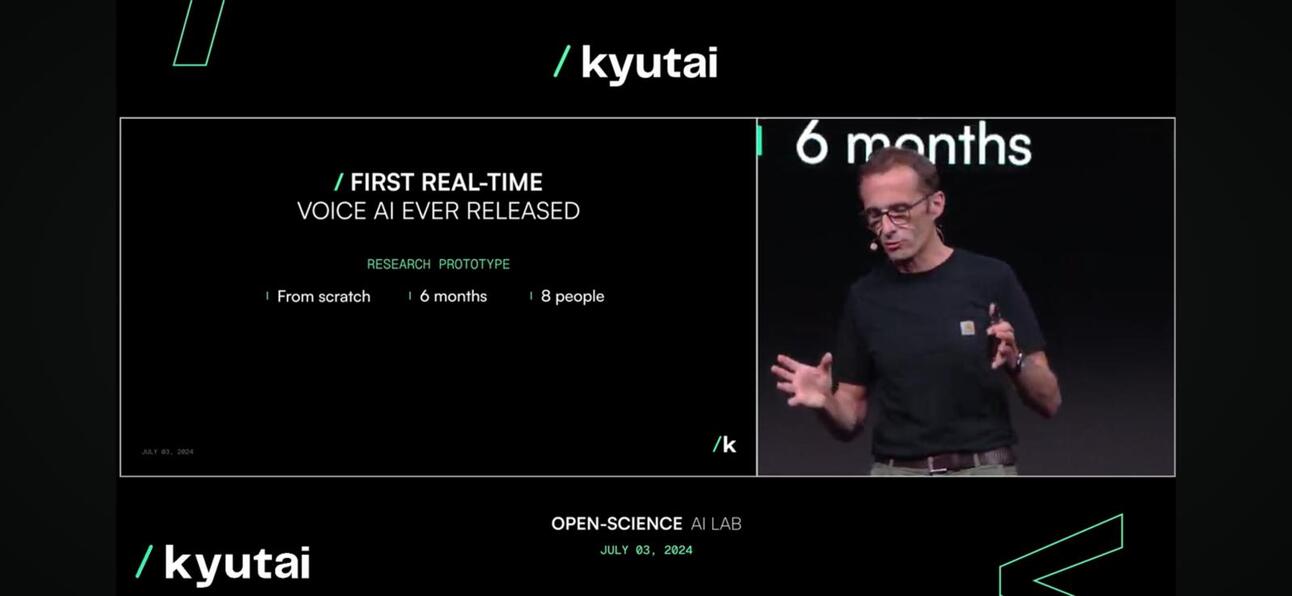

규타이 어제 Moshi를 공개했습니다. Moshi는 듣고 말할 수 있는 실시간 오픈소스 네이티브 멀티모달 기반 모델로, 발표회와 온라인에서 큰 반향을 일으켰습니다.

왜 그렇게 흥미로운가요?

Moshi는 입력과 출력에 다른 악센트를 사용하여 감정을 이해하고 표현할 수 있습니다. 또한 텍스트적 사고의 흐름을 유지하면서 오디오와 음성을 듣고 생성할 수도 있습니다. Moshi는 또한 두 개의 오디오 스트림을 동시에 처리할 수 있어 동시에 듣고 말할 수 있습니다.

인간(혹은 스카이넷)에 훨씬 더 가깝습니다.

이게 왜 그렇게 새로운 건가요?

- 대화의 질. 음성 톤은 전화 통화와 같은 음성 대화의 70%를 차지하는 반면 단어는 나머지 30%를 차지합니다. Kyutai 팀은 오디오 언어 모델 오디오를 "가짜 단어"로 변환하고 이전 오디오에서 다음 오디오 세그먼트를 예측하여 자연스러운 대화를 이어받아 음성 대화의 70%를 개선합니다.

- 대화 지연. 자연스러운 대화를 하기 위해 허용할 수 있는 최대 지연 시간은 약 150밀리초입니다. 첫 번째 릴리스인 Moshi 모델은 160ms에서 200ms 사이의 지연 시간을 제공할 수 있습니다. 완벽하지는 않지만 GPT4o가 약 232~320ms, 그들이 8명의 FTE로 구성된 작은 팀이라는 점을 감안한다면 이는 매우 주목할 만한 일입니다.

실시간으로 달리는 모시

실시간으로 달리는 모시 - 접근성. 이 모델은 노트북이나 휴대전화와 같은 기기에서 실행할 수 있어서 소비자가 훨씬 더 쉽게 접근할 수 있습니다.

모델 압축을 통해 에지에서 사용 가능하게 만들기

모델 압축을 통해 에지에서 사용 가능하게 만들기

그래서요?

- 사업주 또는 기업체에, 고객 상호작용은 모든 비즈니스의 중심입니다. 대부분의 기업이 AI 전략을 개발함에 따라 채팅을 통한 고객 경험을 개선하기 위해 LLM을 활용하는 것이 핵심 부분이지만 텍스트 기반입니다. 이 전략의 다음 단계는 음성 수준에서 고객 경험을 개선하는 것입니다. 즉, 멀티 모달리티 모델이라고 알려진 것으로, 바로 지평선 너머에 있습니다.

- 스타트업에, 폐쇄형 소스 또는 오픈 소스 LLM을 래핑하는 것은 더 이상 통하지 않습니다. 앱에 음성 프롬프트를 어떻게 임베드합니까? Perplexity는 지금 음성 기반 프롬프트에 대한 유료 기능을 도입하고 있습니다. 아직은 좋지 않지만 트렌드입니다.

- 이게 아시아에 어떤 문제야?? 아시아, 특히 동남아시아는 비동질적인 시장이며, 언어와 지역 대화의 차이는 사업 확장의 핵심 과제입니다. LLM 및 Voice 모델은 개인과 기업이 이 지역을 탐색하는 데 도움이 되는 이 과제를 해결하는 좋은 방법입니다. 전화 제조업체, 특히 중국 제조업체는 이 과제와 기회를 해결하기 위한 조치를 취하고 있습니다.

그들은 어떻게 그것을 했을까?

Kyutai는 70억 개의 매개변수 언어 모델인 Helium을 개발하고, 해당 언어 모델의 합성 텍스트와 오디오 데이터를 조합하여 Moshi를 사전 훈련했습니다. 조금 더 깊이 파고들어 Moshi의 미세 조정에는 Text-to-Speech(TTS) 기술로 변환된 100,000개의 합성 변환이 포함되었고, 음성은 다른 TTS 모델에서 생성된 합성 데이터로 훈련되었습니다.

규타이의 다음 행보는?

기술 보고서와 오픈 모델 버전을 기대할 수 있으며, 향후 반복 작업은 채택을 장려하기 위해 매우 자유롭고 관대한 라이선스 전략을 사용하여 사용자 피드백을 기반으로 개선될 것입니다.

전체 기조연설을 시청하려면 클릭하세요. 여기.

마지막으로 동쪽을 조심하세요. 두바오 가장 풍부한 비디오와 오디오 콘텐츠를 보유한 Bytedance의 모델이 이 분야에서 가장 강력한 플레이어가 될 것입니다.

최신 블로그 게시물을 업데이트하려면 구독하세요

댓글을 남겨주세요: