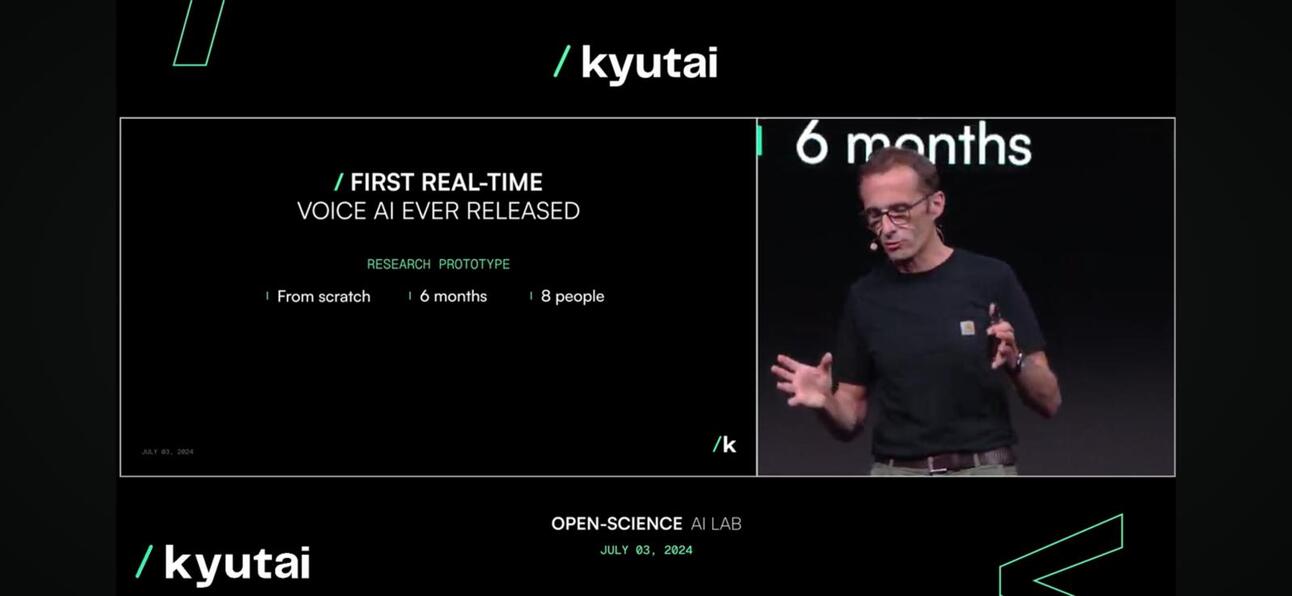

九大 は昨日、聞くことと話すことができるリアルタイムのオープンソースネイティブマルチモーダル基盤モデルであるMoshiを発表し、プレゼンテーションとオンラインで興奮の騒動を引き起こしました。

なぜそんなに興奮するのでしょうか?

Moshi は、入力と出力に異なるアクセントを使用して、感情を理解して表現することができます。また、テキストの思考の流れを維持しながら、音声とスピーチを聞き、生成することもできます。Moshi は、一度に 2 つのオーディオ ストリームを処理することもできるため、聞きながら話すこともできます。

人間(またはスカイネット)に非常に近いです。

これの何が新しいのでしょうか?

- 会話の質音声会話(電話など)では、声のトーンが70%を占め、言葉が残りの30%を占める。Kyutaiチームは、 音声言語モデル 音声を「疑似単語」に変換し、前の音声から次の音声セグメントを予測して自然な会話を継承し、音声会話の質を向上させます。

- 会話の遅延自然な会話をするために許容できる最大遅延は約150ミリ秒です。最初のリリースとして、Moshiモデルは160ミリ秒から200ミリ秒の遅延を実現できます。完璧ではありませんが、GPT4oが約150ミリ秒であることを考えると、 232~320ミリ秒 特に、彼らのチームの規模が FTE 8 人という小規模であることを考えると、これはかなり注目に値することです。

モシ、リアルタイムで実行中

モシ、リアルタイムで実行中 - アクセシビリティ。 このモデルはノートパソコンや携帯電話などのデバイス上で実行できるため、消費者にとってはるかにアクセスしやすくなります。

エッジで利用できるようにモデルを圧縮する

エッジで利用できるようにモデルを圧縮する

だから何?

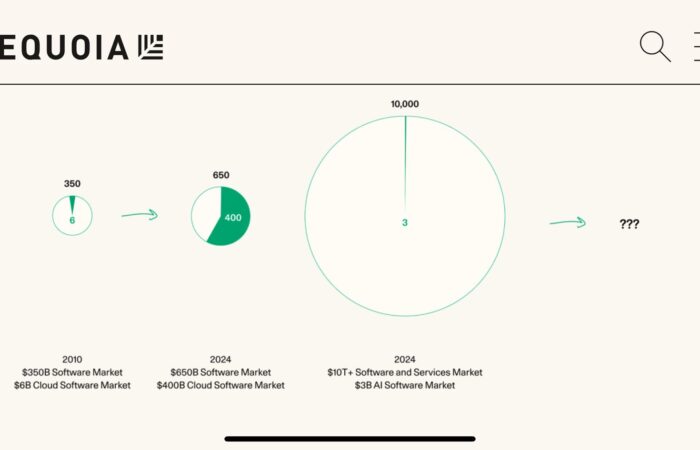

- 事業主または企業向け顧客とのやり取りは、あらゆるビジネスの中心です。ほとんどの企業が AI 戦略を展開している中、LLM を活用してチャットでの顧客体験を向上させることは、テキストベースではありますが、その重要な部分です。この戦略の次の段階は、音声レベルでの顧客体験の向上、つまりマルチモダリティ モデルと呼ばれるもので、もうすぐ実現します。

- スタートアップへクローズドソースまたはオープンソースの LLM をラップするだけでは、もはや十分ではありません。音声プロンプトをアプリに埋め込むにはどうすればよいでしょうか? Perplexity は現在、音声ベースのプロンプトの有料機能を導入しています。まだ素晴らしい機能ではありませんが、トレンドになっています。

- これはアジアにとってどうなのかアジア、特に東南アジアは非均質な市場であり、言語と現地の会話の違いがビジネス拡大の大きな課題となっています。LLM と音声モデルは、個人や企業がこの地域をうまく乗り切る上でこの課題を解決する優れた方法です。携帯電話メーカー、特に中国のメーカーは、この課題と機会に取り組むための措置を講じています。

彼らはどうやってそれをやったのですか?

Kyutai は 70 億のパラメータを持つ言語モデル Helium を開発し、この言語モデルからの合成テキストと音声データの組み合わせで Moshi を事前トレーニングしました。さらに詳しく見てみると、Moshi の微調整には、テキスト読み上げ (TTS) 技術で変換された 10 万の合成変換が含まれ、その音声は別の TTS モデルによって生成された合成データでトレーニングされました。

キュータイの次は何ですか?

技術レポートとオープン モデル バージョンが期待できます。今後のバージョンは、採用を促進するために、非常に自由で寛容なライセンス戦略を使用して、ユーザーからのフィードバックに基づいて改良される予定です。

基調講演の全編をご覧になるには、 ここ.

最後に、東側に注意してください。 ドゥバオ 最も豊富なビデオとオーディオコンテンツを持つバイトダンスのモデルは、この分野で最も強力なプレーヤーとなるでしょう。

最新のブログ投稿の更新情報を受け取るには購読してください

コメントを残す: