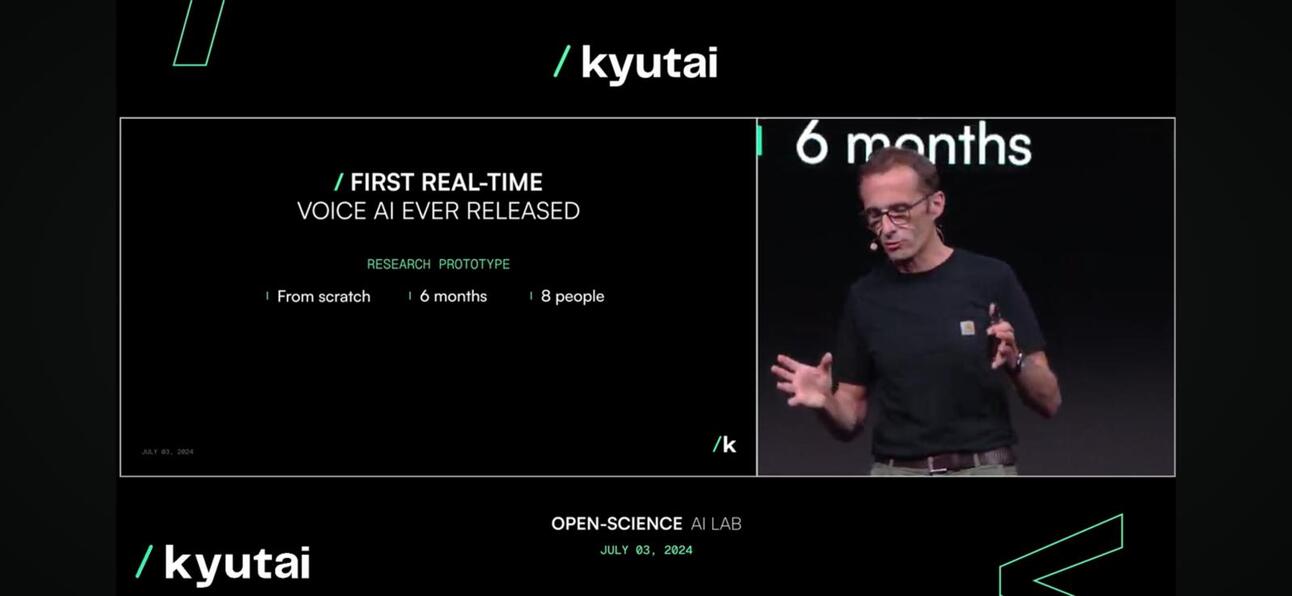

Kyutai kemarin meluncurkan Moshi, sebuah model fondasi multimoda asli sumber terbuka waktu nyata yang dapat mendengarkan dan berbicara, yang menimbulkan kehebohan dalam presentasi dan daring.

Mengapa ini begitu menarik?

Moshi mampu memahami dan mengekspresikan emosi, dengan aksen yang berbeda untuk input dan output. Ia juga dapat mendengarkan dan menghasilkan audio dan ucapan sambil mempertahankan aliran pikiran tekstual. Moshi juga dapat menangani dua aliran audio sekaligus, yang memungkinkannya untuk mendengarkan dan berbicara pada saat yang bersamaan.

Jauh lebih dekat dengan manusia (atau Skynet).

Apa yang baru tentang ini?

- Kualitas percakapanNada suara mencakup 70% percakapan suara, misalnya panggilan telepon, sedangkan kata-kata mencakup 30% sisanya. Tim Kyutai memperkenalkan model bahasa audio yang mengubah audio menjadi “kata-kata semu” dan memprediksi segmen audio berikutnya dari audio sebelumnya untuk menyampaikan percakapan alami guna meningkatkan 70% percakapan suara.

- Latensi Percakapan. Latensi maksimum yang dapat kami toleransi untuk melakukan percakapan alami adalah sekitar 150 milidetik. Sebagai rilis pertama, model Moshi dapat memberikan latensi antara 160 ms dan 200 ms. Tidak sempurna, tetapi mengingat GPT4o sekitar 232 hingga 320 ms, ini sungguh luar biasa, terutama mengingat ukuran tim mereka kecil, yakni 8 FTE.

Moshi, berlari secara real time

Moshi, berlari secara real time - Aksesibilitas. Model ini dapat berjalan pada perangkat seperti laptop atau telepon seluler, yang membuatnya lebih mudah diakses oleh konsumen.

kompresi model untuk membuatnya tersedia di tepi

kompresi model untuk membuatnya tersedia di tepi

Jadi apa?

- Kepada pemilik bisnis atau perusahaan, interaksi pelanggan adalah inti dari setiap bisnis. Karena sebagian besar perusahaan mengembangkan strategi AI mereka, memanfaatkan LLM untuk meningkatkan pengalaman pelanggan melalui obrolan adalah bagian penting darinya, namun berbasis teks. Fase berikutnya dari strategi ini adalah meningkatkan pengalaman pelanggan pada tingkat suara, atau yang dikenal sebagai model multi-modalitas, yang sudah di depan mata.

- Ke perusahaan rintisan, membungkus LLM sumber tertutup atau sumber terbuka tidak akan berhasil lagi. Bagaimana Anda menyematkan perintah suara ke dalam aplikasi Anda? Perplexity kini memperkenalkan fitur berbayar untuk perintah berbasis suara. Fitur ini belum bagus, tetapi sedang menjadi tren.

- Bagaimana hal ini berhubungan dengan Asia?? Asia, khususnya Asia Tenggara, merupakan pasar yang tidak homogen, dan perbedaan bahasa serta dialog lokal merupakan tantangan utama bagi perluasan bisnis. Model LLM dan Voice merupakan cara yang hebat untuk mengatasi tantangan ini dalam membantu individu dan bisnis menjelajahi kawasan tersebut. Para pembuat ponsel, khususnya produsen ponsel asal Tiongkok, tengah mengambil langkah untuk mengatasi tantangan dan peluang ini.

Bagaimana mereka melakukannya?

Kyutai mengembangkan Helium, model bahasa dengan 7 miliar parameter, dan melatih Moshi terlebih dahulu dengan kombinasi teks sintetis dan data audio dari model bahasa tersebut. Jika ditelusuri lebih dalam, penyempurnaan Moshi melibatkan 100.000 konversi sintetis yang dikonversi dengan teknologi Text-to-Speech (TTS), dan suaranya dilatih pada data sintetis yang dihasilkan oleh model TTS lain.

Apa yang selanjutnya untuk Kyutai?

Kita dapat mengharapkan laporan teknis dan versi model terbuka; iterasi masa depan akan disempurnakan berdasarkan masukan pengguna dengan strategi lisensi yang sangat liberal dan permisif untuk mendorong adopsi.

Untuk menonton keynote selengkapnya, silakan klik Di Sini.

Terakhir, perhatikan bagian Timur; Doubao model dari Bytedance, yang memiliki konten video dan audio terkaya, akan menjadi pemain paling tangguh di bidang ini.

Berlangganan untuk Mendapatkan Pembaruan Posting Blog Terbaru

Tinggalkan Komentar Anda: