« La prochaine étape de l'IA s'appelle l'IA physique. L'IA physique est l'endroit où l'IA interagit avec le monde physique. Cela signifie la robotique. » – Jensen Huang, Nvidia, lors d'une cérémonie d'ouverture d'une usine dans le centre de Taïwan le 16 janvier 2025.

Cette année, le CES a mis l'accent sur l'intégration de l'IA dans le matériel, des objets connectés aux meubles dotés d'IA en passant par les robots ! Ce ne sont pas les robots mécaniques peu sexy que les entrepôts ont adoptés (ceux que l'on voit dans les films de science-fiction) qui ont volé la vedette, mais ceux qui ressemblent à des humains.

Nous pouvons dire que la robotique vit un « moment » ChatGPT (comme si la technologie n’était pas nouvelle, mais que l’intérêt du public et du capital avait connu un réveil)

L'année dernière, nous avons notamment pu constater comment l'IA générative a radicalement transformé la robotique. Les robots auparavant contrôlés par une télécommande peuvent désormais « penser » par eux-mêmes, en intégrant l'IA dans la machine grâce à une intégration matérielle et logicielle transparente. Nous assistons à la fusion des débuts de deux domaines scientifiques très différents : le LLM/Gen AI et la robotique.

La semaine dernière, il a été rapporté que OpenAI a secrètement rouvert sa division robotique après l'avoir fermée en 2020. Selon l'entreprise, sa nouvelle équipe de robotique se concentrera sur « le déblocage de la robotique à usage général et la progression vers une intelligence de niveau AGI dans des environnements dynamiques et réels ».

[Je publierai dans quelques semaines une analyse approfondie d'Unitree, la principale entreprise de robotique humanoïde et quadrupède à IA incarnée, alors restez à l'écoute.]

Ce que j’ai trouvé utile, c’est d’utiliser ce cadre pour essayer de comprendre l’IA physique, de considérer l’ensemble comme un processus continu en trois étapes :

- Détection (les yeux, les oreilles et les mains du robot — technologie sensorielle),

- La réflexion (le processus de prise de décision — GenAI),

- et l’action (la capacité d’agir et d’avoir un impact dans le monde physique – la mécatronique).

D'une manière plus technique pour catégoriser cela, Diana Wolf Torres, une écrivaine spécialisée en IA, a déclaré que l'architecture du système peut être décomposée en :

1) Couche de perception : c'est là que la machine traite les entrées sensorielles multimodales grâce à des algorithmes avancés de fusion de capteurs. Cela aide l'ordinateur à mieux comprendre l'environnement physique qui l'entoure.

2) Couche cognitive : c'est le cœur de l'intégration de l'IA dans les robots traditionnels. Elle fait office de cerveau décisionnel de la machine, traitant les données collectées à partir de sa couche de perfectionnement sur la base de simulations pré-entraînées pour décider comment réagir au monde physique.

3) Couche d'action : cette couche crée réellement la « sortie » vers le monde physique, garantissant la précision de son mouvement et l'endroit où nous verrons le saut, la marche ou l'objet en mouvement.

Et l'IA physique englobe tellement de choses : 1) les véhicules autonomes (sur lesquels je travaille), 2) les robots spécialisés - l'automatisation des entrepôts et du travail (traditionnellement ce que nous connaissons), et 3) les robots humanoïdes.

Avertissement : Aujourd'hui, nous allons nous concentrer uniquement sur les robots humanoïdes. J'ai fait de mon mieux pour rendre mes pensées logiques en les notant et en essayant de comprendre l'évolution de la relation entre les robots et l'IA.

Robots humanoïdes

Tout d’abord, qu’est-ce que l’IA incarnée ?

IA incarnée fait référence aux agents d’intelligence artificielle (IA) — robots, assistants virtuels ou autres systèmes intelligents — qui peuvent interagir avec un environnement physique et en tirer des enseignements.Définition de Qualcomm)

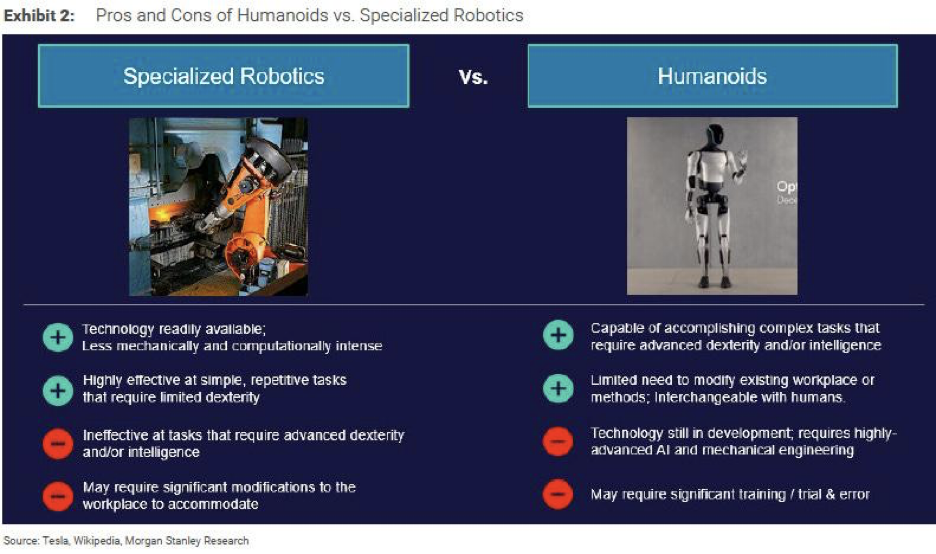

Depuis de nombreuses années, nous nous sommes habitués à des bras robotisés pour les entrepôts, à des robots pour faire du café partout à Tokyo et Shanghai, à des chiens robotisés pour le divertissement et les livraisons, et à d'autres appareils de ce type. Mais ces robots ont un peu perdu leur effet « wow ».

Il y a une dizaine d'années, un ami de la famille a investi dans un restaurant robotisé à Pékin. C'était une machine capable de couper et de préparer une dizaine de plats programmés dans la machine. Ma mère trouvait ça super cool, mais le robot ne ressemblait pas à un humain, juste à une autre machine, donc la nouveauté ne m'a pas plu (je suis presque sûr qu'ils ont fermé le magasin après un an). Les plats étaient bons, mais cuisiner n'est pas une science ; il faut sentir le feu et savoir quelle quantité de sel ajouter. Parfois, il faut pimenter les choses et improviser. Le cas d'utilisation le plus approprié est celui d'une grande cafétéria d'université/campus, d'usines ou de prisons où il faut fournir de la nourriture standardisée à grande échelle de manière efficace. Cela ne fonctionnait tout simplement pas comme un restaurant de milieu de gamme dans le quartier central des affaires de Pékin. Il existe de nombreuses autres options meilleures pour y manger qu'une nourriture au goût médiocre préparée par un robot.

Maintenant, nous allons présenter les humanoïdes, des robots conçus physiquement comme des humains. Ils ont deux bras, deux jambes et une tête, et leur mobilité imite celle de notre corps.

« Les robots les plus faciles à adapter au monde sont les robots humanoïdes, car nous avons construit le monde pour nous », a déclaré Jensen Huang au Computex, ajoutant : « Il y a plus de données pour entraîner ces robots car nous avons le même physique. »

Et je suis d'accord avec lui. Notre obsession pour les robots à l'apparence humaine dépasse désormais notre égoïsme et notre suffisance en tant qu'êtres humains. C'est une question d'optique, mais aussi de pragmatisme. Donc maintenant, cela ressemble de plus en plus à Moi, Robot.

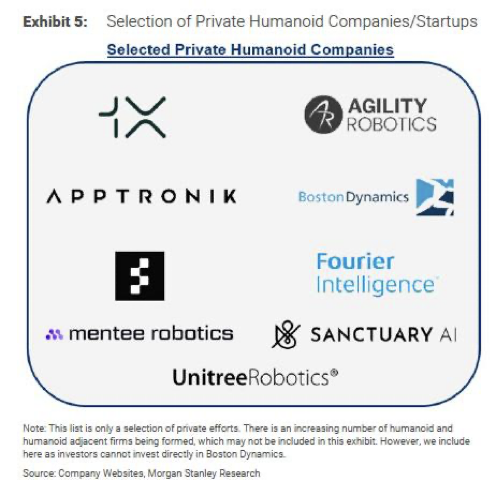

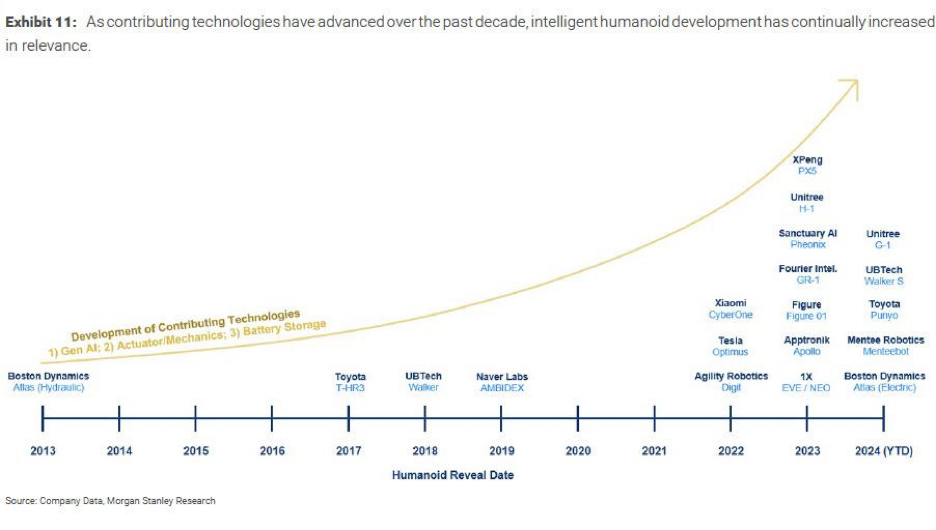

L’intérêt général pour les robots humanoïdes a commencé fin 2022 lorsque Tesla a dévoilé son Optimus. Depuis lors, de nombreuses entreprises de robotique ont attiré l’attention des médias et des investisseurs du monde entier. C’est devenu la nouvelle forme de robot « wow ».

En quoi sont-ils différents des robots traditionnels ?

La robotique traditionnelle existe depuis plus d’une décennie. Ces robots conventionnels s’appuyaient sur une programmation rigide pour exécuter des instructions pré-écrites (en suivant un ensemble d’ordres et sans pouvoir « penser »). Les robots traditionnels se limitaient essentiellement à des mouvements répétitifs et préprogrammés avec peu de flexibilité, et la complexité des tâches qu’ils pouvaient gérer était limitée. Alors que les robots à IA incarnée sont formés sur des données du monde réel qui utilisent l’apprentissage par renforcement et ils ont développé la capacité de « penser ».

En octobre 2024, lors d'un appel vidéo lors d'une conférence technologique à Riyad, Elon Musk a prédit que d'ici 2040, il y aurait au moins 10 milliards de robots humanoïdes dont le prix se situerait entre 20 000 et 25 000 THB. via un appel vidéo lors d'une conférence technologique à Riyad. Bien que nous en soyons encore loin, nous sommes un peu plus près de voir les robots devenir plus accessibles/plus répandus avec les modèles de robots de pointe de Amérique, Tesla, Agility Robotics, Unitree, etc.

Lors de sa dernière assemblée générale, Elon Musk, le PDG de Tesla, a prédit que les humanoïdes seraient deux fois plus nombreux que les humains à l’avenir, voire plus. C’est fou (et effrayant).

Et juste aujourd'hui, David Soloman, PDG de Goldman Sachs, a déclaré que L'IA va révolutionner la productivité des entreprises. Selon lui, à terme, une grande partie des tâches des banquiers juniors sera remplacée par l'IA, comme la rédaction des documents de dépôt d'introduction en bourse 95%, qui peut désormais être réalisée par l'IA en quelques minutes, « Les 5 % restants comptent désormais, car le reste est désormais une marchandise. »

Les dirigeants observent cette révolution et pensent vraiment que les robots IA nous remplaceront (nous assisteront) un jour.

Développement et limites

Discours d'ouverture de Nvidia en mars 2024 L'accent est également mis sur l'IA physique et la robotique. L'avancement des robots repose sur trois facteurs principaux : 1) l'IA générale, 2) les actionneurs et la mécanique, et 3) le stockage sur batterie (que j'ai également évoqué auparavant lorsque j'ai écrit sur les solutions d'énergie renouvelable ici)

Si ces trois facteurs peuvent progresser ensemble, la mise à l’échelle et la commercialisation à grande échelle de la robotique humanoïde se feront probablement dans quelques années. Dans l’article d’Unitree, je parle de la Chine, compte tenu de sa longue expérience dans la fabrication de matériel informatique, qui lui a donné un avantage en matière de savoir-faire dans la mécatronique, qui combine la technologie mécanique et l’électronique, étant donné qu’elle est le centre de fabrication de matériel pour divers appareils au cours des dernières décennies. Bien que les États-Unis soient toujours à la pointe de la GenAI, la question est de savoir quel facteur compte le plus, ou y aura-t-il une intention de collaboration ? Et qui peut trouver la dernière pièce ? Une meilleure solution de batterie. Peuvent-ils fabriquer des batteries plus légères, plus durables et plus sûres ?

Nous, les humains, rêvons depuis des décennies d'un monde où les robots vivent à nos côtés, depuis le film Her en 2013, où nous avons imaginé un amoureux virtuel IA (où cela peut pratiquement être réel maintenant), jusqu'au thriller de science-fiction de 2024 mettant en vedette Megan Fox Subservience, où l'IA physique remet en question notre morale de fidélité, de loyauté et conduit même à des risques de sécurité préjudiciables. L'imagination a toujours été que nous aurons un jour des robots créés. C'est juste que maintenant, la technologie a enfin suffisamment progressé pour rattraper notre imagination. (Évidemment, les humanoïdes actuels ne ressemblent pas encore à Megan Fox)

Un robot qui tombe amoureux de l'humain et devient méchant dans le film /Subservience/

Protagoniste humain qui tombe amoureux d'un agent vocal IA dans le film /Her/

Donc, pour en revenir à mon point de vue, ce n’est évidemment qu’un début. Comme toutes les ressources sont désormais consacrées à l’IA physique (ou à l’IA en général), ce domaine interdisciplinaire va mûrir et continuer à progresser plus vite que nous ne pouvons peut-être même l’imaginer. Alors que nos mondes physique et numérique continuent de se modeler et de se fondre l’un dans l’autre, les problèmes de sécurité m’inquiètent vraiment en tant que mère d’un enfant de 2 ans. Si les smartphones perturbent déjà les enfants sur la réalité, comment devrions-nous réglementer cette technologie et de quoi les robots seront-ils capables lorsqu’ils atteindront l’adolescence ?

Il reste encore beaucoup à déballer, je vais donc ajouter une nouvelle verticale à AI Proem : IA physique. Dans Dans ce vertical, j'explorerai les nombreux domaines qui peuvent affecter le développement de l'IA physique. Tout d'abord, je ferai une plongée en profondeur dans la principale société chinoise de robots humanoïdes, Unitree Robotics, qui est souvent comparée à Boston Dynamics. J'explorerai également l'angle de la solution de batterie, que j'ai essayé de trouver le temps d'examiner après mon article sur les énergies renouvelables.

Ensuite, je pense qu’il sera intéressant d’explorer les inquiétudes autour des théories possibles sur la façon dont les robots deviendront des voyous. Cela concerne la sécurité globale de la robotique et la dextérité des machines robotisées. Ensuite, il y a les aspects techniques de la connectivité, de la bande passante, des complications de latence et d’autres composants clés – capteurs (LIDAR), fusion de capteurs et technologie d’architecture logicielle. Cela est également lié à un autre travail en cours qui examinera comment les entreprises de véhicules électriques sont en train de passer à des entreprises axées sur l’IA, suivant les traces de Tesla (Li Auto, par exemple).

Je souhaite également élargir ma couverture pour inclure la manière dont l’IA affectera notre flux de travail. J’explore donc comment notre main-d’œuvre sera impactée par l’adoption de l’IA physique et j’étudie ensuite potentiellement les logiciels d’IA à venir ou comment l’IA affectera nos plateformes logicielles les plus populaires de l’ère Internet.

Il y a tellement de choses à apprendre et à écrire ! Pour l'instant, toodeloo~

Merci d'avoir lu Projet d'IA! Abonnez-vous gratuitement pour recevoir de nouveaux articles et soutenir mon travail.

Abonnez-vous pour recevoir les dernières mises à jour du blog

Laissez votre commentaire: