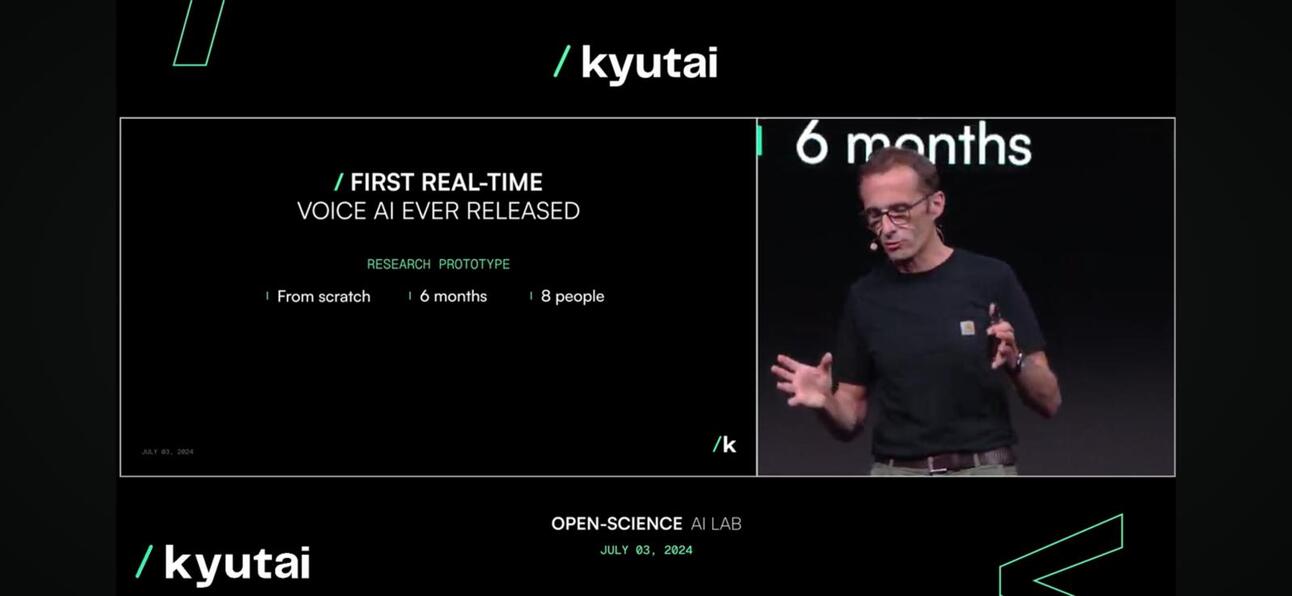

Kyutai a dévoilé hier Moshi, un modèle de fondation multimodal natif open source en temps réel qui peut écouter et parler, provoquant un tollé enthousiaste lors de la présentation et en ligne.

Pourquoi c'est si excitant ?

Moshi est capable de comprendre et d'exprimer des émotions, avec différents accents pour l'entrée et la sortie. Il peut également écouter et générer de l'audio et de la parole tout en maintenant un flux de pensées textuelles. Moshi peut également gérer deux flux audio à la fois, ce qui lui permet d'écouter et de parler en même temps.

Beaucoup plus proche d'un être humain (ou de Skynet).

Qu'y a-t-il de si nouveau là-dedans ?

- Qualité de la conversationLe ton de la voix représente 70% de conversations vocales, par exemple, les appels téléphoniques, tandis que les mots représentent les 30% restants. L'équipe Kyutai a introduit un modèle de langage audio qui convertit l'audio en « pseudo-mots » et prédit le segment audio suivant à partir de l'audio précédent pour poursuivre une conversation naturelle afin d'améliorer 70% des conversations vocales.

- Latence de conversation. La latence maximale que nous pouvons tolérer pour avoir une conversation naturelle est d'environ 150 millisecondes. En tant que première version, le modèle Moshi peut offrir une latence comprise entre 160 ms et 200 ms. Ce n'est pas parfait, mais compte tenu du fait que GPT4o est d'environ 232 à 320 ms, c'est assez remarquable, surtout compte tenu du fait qu'il s'agit d'une petite équipe de 8 ETP.

Moshi, en cours d'exécution en temps réel

Moshi, en cours d'exécution en temps réel - Accessibilité. Le modèle peut fonctionner sur un appareil tel qu’un ordinateur portable ou un téléphone mobile, ce qui le rend beaucoup plus accessible aux consommateurs.

compression du modèle pour le rendre disponible en périphérie

compression du modèle pour le rendre disponible en périphérie

Et alors ?

- À un propriétaire d'entreprise ou à une entreprise, les interactions avec les clients sont la pièce maîtresse de toute entreprise. Alors que la plupart des entreprises développent leur stratégie d'IA, l'exploitation d'un LLM pour améliorer l'expérience client via le chat en est un élément clé, mais basé sur le texte. La prochaine phase de cette stratégie consiste à améliorer l'expérience client au niveau vocal, ou ce que l'on appelle un modèle multimodal, qui se profile à l'horizon.

- Vers une startup, encapsuler un LLM fermé ou open source ne suffit plus. Comment intégrer une invite vocale dans votre application ? Perplexity introduit désormais une fonctionnalité payante pour les invites vocales. Ce n'est pas encore génial, mais c'est tendance.

- En quoi cela concerne-t-il l’Asie ?? L’Asie, en particulier l’Asie du Sud-Est, est un marché hétérogène, et les différences de langue et de dialogue local constituent des défis majeurs pour l’expansion des entreprises. Le modèle LLM et Voice est un excellent moyen de résoudre ce défi en aidant les particuliers et les entreprises à s’orienter dans la région. Les fabricants de téléphones, en particulier les fabricants chinois, prennent des mesures pour relever ce défi et saisir cette opportunité.

Comment ont-ils fait ?

Kyutai a développé Helium, un modèle linguistique à 7 milliards de paramètres, et a pré-entraîné Moshi avec une combinaison de données textuelles et audio synthétiques issues de ce modèle linguistique. En approfondissant un peu plus, le réglage fin de Moshi a impliqué 100 000 conversions synthétiques converties avec la technologie Text-to-Speech (TTS), et sa voix a été entraînée sur des données synthétiques générées par un autre modèle TTS.

Quelle est la prochaine étape pour Kyutai ?

Nous pouvons nous attendre à un rapport technique et à des versions de modèles ouverts ; les itérations futures seront affinées en fonction des commentaires des utilisateurs avec une stratégie de licence ultra-libérale et permissive pour encourager l'adoption.

Pour regarder le discours complet, veuillez cliquer sur ici.

Enfin, attention à l'Est ; Doubao Le modèle de Bytedance, qui possède le contenu vidéo et audio le plus riche, sera l'acteur le plus redoutable dans cet espace.

Abonnez-vous pour recevoir les dernières mises à jour du blog

Laissez votre commentaire: