Présentation de Leo's Takes

En tant qu'ancien CDO de Huawei Cloud et ayant développé l'un des plus grands écosystèmes de startups de la région, j'ai eu un accès direct à :

- Organisation et équipe qui développent des chipsets GPU, des LLM (Large language model) et d'autres LM (large models) ;

- Les entreprises qui se lancent dans leur parcours de transformation vers l’IA ; et

- Des startups d'IA de l'Est et de l'Ouest créent des LLM, des outils et des applications GenAI.

En quoi cela est-il pertinent pour vous ?

- Si vous êtes un dirigeant d'entreprise ou professionnel, cet article vous fournira une vue complète du paysage technologique actuel du LLM et de la GenAI et des informations pratiques sur les risques et opportunités sous-jacents.

- Si vous êtes un fondateur ou investisseur, cet article vous aidera à comprendre les pièges et les véritables opportunités dans votre quête de l'IA.

Les opinions de Leo ci-dessous sont le fruit d'une combinaison de mon expérience et d'une étude de marché, y compris des ateliers, des entretiens et des discussions avec des praticiens du secteur concerné. Ces praticiens comprennent des analystes de recherche, des développeurs, des dirigeants d'entreprise et des fondateurs, ce qui garantit une perspective complète et crédible.

La situation actuelle des programmes GenAI et LLM

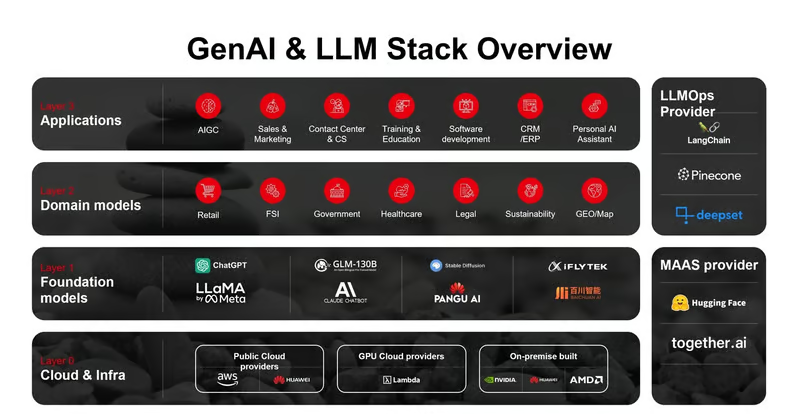

La pile technologique GenAI et LLM s'est stabilisée, et chacune des couches suivantes possède son propre modèle économique, ses propres défis et ses propres opportunités. Il est essentiel de comprendre ces couches pour s'orienter dans le paysage de l'IA et prendre des décisions commerciales éclairées.

Couche 0 (Cloud et infrastructure) – « Là où se trouve l’argent »

Cette couche est le métal nu qui sous-tend l'ensemble de la pile GenAI. Elle représente plus de 80% de la valeur totale de GenAI économie. Bien que Nvidia domine certainement, avec près de 95% du marché des fabricants de puces (Nvidia bat Apple avec une capitalisation boursière de 3T), le marché attire d'autres grands acteurs, par exemple Huawei. Jensen Huang a identifié Huawei comme l'un des des rivaux « redoutables » pour NVIDIA, notamment sur le marché des puces IA. Parallèlement, il attire également des startups, des innovateurs, par exemple Grog, qui abordent le marché avec des puces spécialement conçues, les LPU (unité de traitement du langage), qui se concentrent sur les performances et la précision de l'inférence de l'IA.

Le point de vue de Léo : Le plus grand atout de Nvidia ne réside pas seulement dans ses puissants chipsets, mais aussi dans l'écosystème Cuda qu'elle a construit au fil des ans. Elle soutient les développeurs avec :

- Différents langages et API ;

- Bibliothèque et framework pour différentes tâches de domaine ;

- Outils de développement ; et

- Partenaires de l'écosystème

Alors que d’autres comme Huawei et AMD proposent des produits similaires, la facilité d’utilisation et la richesse de leurs écosystèmes se situent à des échelles différentes. Les développeurs doivent donc déployer beaucoup plus d’efforts pour créer des modèles qui fonctionnent avec la puce sous-jacente, ce qui rend le coût de la migration de Nvidia vers d’autres fabricants de puces un obstacle important. Pour une société cotée comme AMD, la décision de se concentrer sur le développement de l’écosystème est difficile car elle nécessite un investissement à long terme et ne rapportera pas de rendement à court ou moyen terme. Huawei, en tant qu’entreprise non cotée en bourse, a un avantage dans ce domaine, mais les sanctions américaines entravent également sa progression.

Couche 1 (Modèles fondamentaux et LLM) – « Qui peut construire la plus grosse bombe ? »

Le moteur de la pile GenAI qui alimente toutes les applications GenAI pilotées par ceux qui peuvent créer les modèles les plus performants, et cela se produit à l'échelle internationale comme nationale, en particulier aux États-Unis et en Chine.

- Course entre Anthropic et OpenAI – Le modèle Claude 3.5 Sonnet surpasse les modèles concurrents; et

- Course entre LLM fermé et LLM open source et l'écart se réduit avec 6 à 10 mois de décalage.

Source: Linkedin

- La « guerre des centaines de LLM en Chine » — la guerre des prix entre des centaines de créateurs de LLM en Chine s'intensifierBytedance a proposé son modèle à 10% du prix du marché à la fin du mois de mai de cette année, suivi des modèles Alibaba Cloud et Baidu avec des prix similaires.

Et nous commençons à voir une « guerre froide de l’IA » entre l’Occident et l’Orient.

- OpenAI prévoit de bloquer l'accès aux API en Chine à partir du 9 juillet, ce qui incite les créateurs de LLM chinois à proposer des alternatives à des dizaines de milliers de développeurs. La Chine a mis en œuvre des mesures provisoires pour l'administration du service d'intelligence artificielle générative en 2023, ce qui a relevé la barre pour le développement de LLM étrangers en Chine.

- Une résolution sur l'intelligence artificielle, proposée par la Chine, est adoptée à l'Assemblée générale des Nations Unies, elle utilise le soft power pour promouvoir le développement de l'IA dans un environnement « libre, ouvert, inclusif et non discriminatoire », en réponse à la tension croissante entre les États-Unis et la Chine.

Le point de vue de Léo : La nature du concours LLM ne se limite pas à la technologie, mais concerne également l'« être intelligent » profondément enraciné dans la culture et la langue du pays ou de la région. Par exemple, l'investissement de $70M SGD de Singapour dans son programme national de modèle multimodal de grande envergure (LLM), connu sous le nom de Sea-lion, témoigne de la ce.

Techniquement, le paysage des LLM finira par converger vers une poignée de modèles, notamment les modèles à code source fermé et les modèles à code source ouvert. Le leader, comme OpenAI, pourrait conserver une avance de 6 à 12 mois sur les autres. Les modèles à code source ouvert comblent rapidement l’écart, étant donné que la plupart des entreprises préfèrent avoir l’option des modèles à code source ouvert, avec le désir de conserver le contrôle et la confidentialité. Le résultat du sondage réalisé lors du forum sur l’IA de l’Economist Intelligence Network auquel j’ai participé à Singapour l’année dernière – montre que plus de 701 TP3T de cadres dirigeants sont ouverts aux LLM à code source ouvert.

Source : AI Business Asia, The Economist Intelligence AI Forum Singapour, 2023

Les entreprises n’évaluent plus la « puissance » des LLM ; elles accélèrent leur transformation GenAI avec des PoC rapides depuis le début de 2024, même si cela reste la norme pour un PoC gratuit ou avec un budget compris entre $50K ~ $100K. Cela crée une « tempête parfaite » pour les couches ci-dessus et la convergence de nouvelles couches.

Couches émergentes et couche de modèle de domaine – « Le champ de bataille des startups B2B »

Le modèle en tant que service (MaaS) est une couche hybride d'infrastructure et une couche de modèle fondamentale. Il offre aux entreprises un accès facile à la puissance des LLM avec des modèles pré-entraînés et réduit les coûts en capital humain. La couche opérationnelle LLM est la couche d'outillage qui aide les entreprises à rationaliser le processus de développement d'applications et à créer des modèles spécifiques à un domaine. Les modèles spécifiques à un domaine sont spécialement formés (affinés) pour un secteur ou une tâche spécifique.

Le point de vue de Léo : C'est le champ de bataille des startups B2B, qui tentent collectivement de résoudre un problème : comment créer des applications GenAI avec une efficacité optimale ?

Le parcours de développement et d’exploitation d’une application GenAI est complexe et a attiré des milliers de startups B2B entrant dans cet espace d’ici 2024, qui croient toutes à l’idée de « vendre des pelles pendant la ruée vers l’or ». Beaucoup d’entre elles se portent bien, par exemple Langchain, Flowiseai. Cependant, les couches émergentes sont des espaces volatils, principalement en raison du rythme de développement de la couche du modèle fondamental (LLM). Les limites et les fonctionnalités des LLM(s) évoluent, ce qui a rendu la première version de LLM obsolète, par exemple GPT3.5 est en cours d’amortissement, et de nouvelles fonctionnalités et capacités qui peuvent chevaucher certains de ces outils sont ajoutées.

Les fournisseurs de services cloud entrent dans l’espace du MaaS, qui proposent des modèles open source pré-entraînés sous forme d’API ; en fin de compte, il s’agit d’une compétition de jetons par seconde et des coûts associés. Cela étant dit, des acteurs comme Huggingface, qui ont construit leurs modèles et organisé une formidable communauté de développeurs, prospèrent toujours ; par exemple, on estime que Huggingface a généré $70M ARR l’année dernière. Je soutiens cette hypothèse, mais je pense que ces revenus sont en grande partie attribués à son partenaire AWS plutôt qu’aux développeurs en fonction du partage des revenus d’inférence de l’IA.

Alors, que faut-il retenir de tout cela ? Parmi les cinq couches, c'est mon espace préféré, et j'ai un immense respect pour les bâtisseurs et les fondateurs de cet espace. Ce sont eux qui créent les « multiples » qui aident l'ensemble de l'écosystème à produire de meilleurs résultats et de la valeur. En même temps, le risque est assez élevé pour les startups et les investisseurs, mais la récompense l'est tout autant.

Que vous soyez fondateur ou investisseur, je pense que les trois facteurs clés de succès (suivez cette séquence) sont :

- Le public d’abord ;

- Le problème vient en second lieu ; et

- Enfin, votre produit.

Il est important de noter que votre public n'est pas nécessairement votre client. Dans de nombreux cas, vous devrez peut-être d'abord développer votre communauté d'audience et générer des revenus à partir d'autres sources, comme dans le cas de Huggingface.

Couche 3 (applications GenAI) – « Le besoin de vitesse »

Il s'agit de la couche la plus impitoyable de toutes, principalement portée par les applications et outils GenAI B2C. a16z a publié les 50 meilleurs produits Web GenAI ; sur la base des visites mensuelles, il montre que plus de 40 % des entreprises de la liste sont nouvelles, par rapport à notre rapport initial de septembre 2023. Ce type de rotation porte sur la capacité et la rapidité de l'entreprise à finaliser l'adéquation produit-marché (PMF). Cela pousse la plupart de ces entreprises B2C à s'entourer de certains LLM bien connus, tels que GPT4 et Llama3, que les investisseurs critiquent souvent pour être une entreprise wrapper.

Source : a16z

Le point de vue de Léo : Il n’y a aucune honte à être une entreprise de type wrapper, car le produit final qui ravit votre client est celui qui compte le plus. Les LLM sous-jacents devenant une marchandise, la façon dont vous orchestrez l’IA, par exemple la latence, l’intégration du flux de travail et l’interface utilisateur, sera la plus importante. Sur ce front, l’agence humaine est au cœur du produit.

Depuis 2023, j’ai interviewé plus de 100 startups d’IA, de la phase d’amorçage à la licorne, entre l’Occident (par exemple les États-Unis et l’UE) et l’Orient (par exemple la Chine et Singapour). Les deux côtés présentent des approches très différentes de la mise sur le marché ; les startups américaines sont très centrées sur le produit, tandis que les startups chinoises sont beaucoup plus flexibles en matière de service. La principale raison est que le marché asiatique exige davantage de personnalisation. C’est l’un des facteurs d’agence humaine qui compte pour le succès des entreprises d’applications. Par cela, je ne parle pas de créer une application si personnalisable que vous pouvez la faire évoluer, mais de la capacité à créer rapidement une application spécifique aux fonctionnalités et destinée à un espace ou à un public de niche. La Chine n’est plus l’usine mondiale que vous connaissez, qui fabrique les produits de consommation que vous utilisez quotidiennement. Elle se prépare désormais à devenir l’usine mondiale des applications d’IA, en particulier compte tenu de la prolifération des applications GenAI.

Consultez mon message, «Un changement de paradigme dans la création d'une startup d'un million de dollars en moins d'un an si vous adoptez la bonne approche.”

Quelle est la source secrète de leur succès ?

Impact sur les startups et les entreprises d'Asie

L’évaluation des LLM et de GenAI est de loin la progression technologique la plus rapide de l’histoire de l’humanité, et elle ne ralentit pas, mais s’accélère. Les plus grands défis pour les cadres dirigeants et les fondateurs ne sont pas de choisir les modèles et les applications, mais de combler les lacunes de connaissances toujours croissantes et d’élaborer une stratégie et une exécution pour garantir que l’IA fonctionne pour eux.

L’Asie est un marché particulièrement prometteur et complexe, étant le continent le plus peuplé et le plus hétérogène. Cependant, elle reçoit souvent moins d’attention de la part des créateurs d’IA aux États-Unis. Par exemple, OpenAI n’a ouvert son premier bureau à Tokyo que cette année, et la majorité des startups américaines spécialisées dans l’IA avec lesquelles j’ai discuté se concentrent uniquement sur les États-Unis et l’UE. Huggingface, par exemple, n’a que quelques employés en Asie. Cette situation représente à la fois un problème et une opportunité pour les fondateurs et les entreprises d’Asie, et il est essentiel d’être conscient de cette dynamique.

Abonnez-vous pour recevoir les dernières mises à jour du blog

Laissez votre commentaire: