“La siguiente etapa de la IA se llama IA física. La IA física es aquella en la que la IA interactúa con el mundo físico. Es decir, robótica”. – Jensen Huang, de Nvidia, en una ceremonia de inauguración de una fábrica en el centro de Taiwán el 16 de enero de 2025.

Este año, el CES se centró en la integración de la IA en el hardware, desde dispositivos portátiles hasta muebles potenciados por IA y robots. Los protagonistas no fueron los robots mecánicos poco atractivos que han adoptado todos los almacenes (los divertidos que vemos en las películas de ciencia ficción), sino los que parecen humanos.

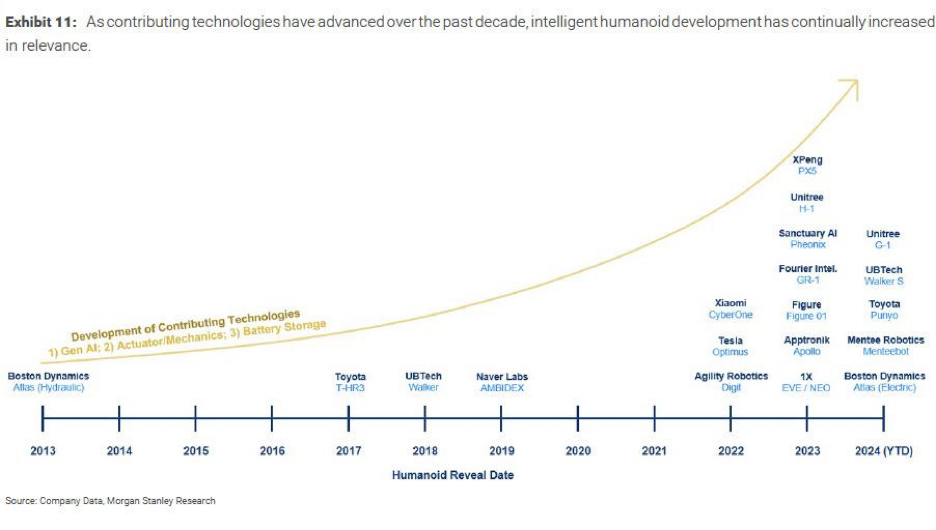

Podemos decir que la robótica está viviendo un “momento ChatGPT” (ya que la tecnología no es nueva, pero el interés público y del capital ha experimentado un despertar).

En particular, el año pasado vimos cómo la IA generativa transformó drásticamente la robótica. Los robots que antes se controlaban con un control remoto ahora pueden "pensar" por sí mismos, integrando la IA en la máquina en una integración perfecta de hardware y software. Estamos viendo cómo se unen los primeros días de dos áreas científicas muy diferentes: LLM/Gen AI y la robótica.

La semana pasada se informó que OpenAI reabrió en secreto su división robótica después de cerrarla en 2020. Según la empresa, su nuevo equipo de robótica se centrará en “desbloquear la robótica de propósito general y avanzar hacia la inteligencia de nivel AGI en entornos dinámicos del mundo real”.

[En unas semanas publicaré un análisis profundo de Unitree, la empresa líder en robótica humanoides y cuadrúpedos con inteligencia artificial encarnada, así que permanezcan atentos].

Lo que me resultó útil fue utilizar este marco al intentar comprender la IA física, para ver todo el asunto como un proceso continuo de tres pasos:

- Detección (los ojos, oídos y manos del robot: tecnología sensorial),

- Pensamiento (el proceso de toma de decisiones—GenAI),

- y actuar (la capacidad de llevar adelante una acción y tener un impacto en el mundo físico: mecatrónica).

De una manera más técnica de categorizar esto, Diana Wolf Torres, escritora de IA, ha dicho que la arquitectura del sistema se puede dividir en:

1) Capa de percepción: aquí es donde la máquina procesa la información sensorial multimodal a través de algoritmos avanzados de fusión de sensores. Ayuda a la computadora a comprender mejor el entorno físico que la rodea.

2) Capa cognitiva: es el núcleo de la integración de la IA en los robots tradicionales. Funciona como el cerebro de toma de decisiones de la máquina, procesando los datos recopilados de su capa de perfección en función de simulaciones previamente entrenadas para decidir cómo reaccionar ante el mundo físico.

3) Capa de acción: esta capa realmente crea la “salida” al mundo físico, asegurando la precisión en su movimiento y dónde veremos el salto, la caminata o el objeto en movimiento.

Y la IA física abarca mucho: 1) vehículos autónomos (en los que estoy trabajando), 2) robots especializados: automatización de almacenes/mano de obra (tradicionalmente lo que conocemos) y 3) robots humanoides.

Descargo de responsabilidad: hoy nos centraremos únicamente en los robots humanoides. Hice todo lo posible por ordenar mis ideas y entender la relación en evolución entre los robots y la IA.

Robots humanoides

En primer lugar, ¿qué es la IA encarnada?

IA encarnada se refiere a los agentes de inteligencia artificial (IA) —robots, asistentes virtuales u otros sistemas inteligentes— que pueden interactuar con un entorno físico y aprender de él.Definición de Qualcomm)

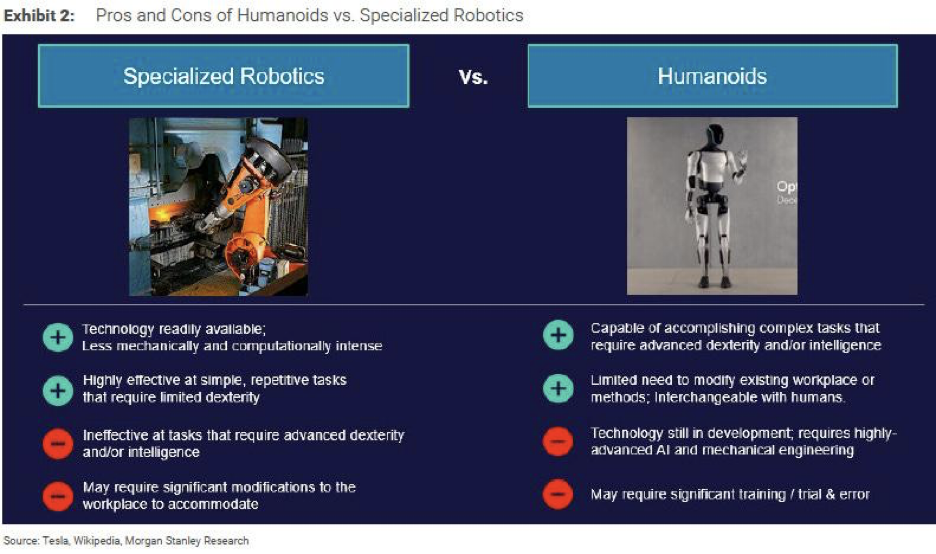

Durante muchos años nos hemos acostumbrado a los brazos robóticos para su uso en almacenes, a los robots que preparan café por todo Tokio y Shanghái, a los perros robóticos para divertirse y hacer entregas y a otros dispositivos similares. Pero estos robots han perdido su factor sorpresa.

Hace unos diez años, un amigo de la familia invirtió en un restaurante robot en Pekín. Era una máquina que podía cortar y preparar unos 10 platos que estaban programados en la máquina. A mi madre le pareció genial, pero el robot no parecía un humano, sino una máquina más, así que la novedad no me gustó (estoy bastante segura de que cerraron la tienda al cabo de un año). Los platos tenían buen sabor, pero cocinar no es una ciencia; hay que sentir el fuego y saber cuánta sal añadir. A veces, hay que darle un toque especial e improvisar. El caso de uso más adecuado es para una gran cafetería universitaria o de campus, fábricas o prisiones donde hay que ofrecer comida estandarizada a gran escala de manera eficiente. Simplemente no funcionó como restaurante de precio medio en el centro de Pekín. Hay muchas otras opciones mejores para comer allí que una comida de sabor mediocre hecha por un robot.

Ahora, vamos a presentarles a los humanoides, robots que están diseñados físicamente como los humanos. Tienen dos brazos, dos piernas y una cabeza, y su movilidad imita la de nuestros cuerpos.

“Los robots más fáciles de adaptar en el mundo son los robots humanoides porque construimos el mundo para nosotros”, dijo Jensen Huang en Computex, y agregó: “Hay más datos para entrenar a estos robots porque tenemos el mismo físico”.

Y estoy de acuerdo con él. Nuestra obsesión con los robots de apariencia humana va más allá de lo egoístas y presuntuosos que seamos como humanos. Es una cuestión de estética, pero también de práctica. Por eso ahora suena cada vez más a... Yo, robot.

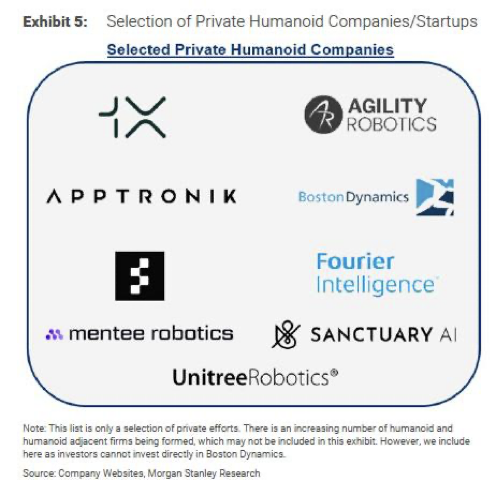

El interés generalizado por los robots humanoides comenzó a finales de 2022, cuando Tesla presentó su Optimus. Desde entonces, muchas empresas de robótica han recibido la atención de los medios de comunicación y de los inversores de todo el mundo. Este se convirtió en el nuevo robot "sorprendente".

¿En qué se diferencian de los robots tradicionales?

La robótica tradicional existe desde hace más de una década. Estos robots convencionales dependían de una programación rígida para ejecutar instrucciones preescritas (siguiendo un conjunto de órdenes y sin poder “pensar”). Los robots tradicionales se limitaban esencialmente a movimientos repetitivos y preprogramados con poca flexibilidad, y la complejidad de las tareas que pueden manejar es limitada. Mientras que los robots de IA corporizados se entrenan con datos del mundo real que utilizan aprendizaje de refuerzo y han desarrollado la capacidad de “pensar”.

En octubre de 2024, durante una videollamada en una conferencia tecnológica en Riad, Elon Musk predijo que para 2040, habría al menos 10 mil millones de robots humanoides con un precio de entre $20,000 y $25,000. A través de una videollamada en una conferencia tecnológica en Riad. Si bien aún estamos lejos de eso, estamos un paso más cerca de que los robots se vuelvan más accesibles y prevalentes con los modelos de robots de vanguardia de Ameca, Tesla, Agility Robotics, Unitree, etc.

En su última asamblea general anual, Musk, el director ejecutivo de Tesla, predijo que en el futuro los humanoides superarán en número a los humanos en una proporción de dos a uno o más. Es una locura (y da miedo).

Y justo hoy, David Soloman, director ejecutivo de Goldman Sachs, dijo que La IA revolucionará la productividad empresarialSu opinión es que, con el tiempo, gran parte de lo que hacen los banqueros junior será reemplazado por IA, como la redacción de documentos de presentación de IPO 95%, que ahora puede completar la IA en minutos. “El último 5 por ciento ahora importa porque el resto ahora es una mercancía”.

Los ejecutivos están observando esta revolución y realmente piensan que los robots de IA nos reemplazarán (nos ayudarán) algún día.

Desarrollo y limitaciones

Discurso inaugural de Nvidia en marzo de 2024 También se centró en la IA física: la robótica. El avance de los robots depende de tres factores principales: 1) GenAI, 2) actuadores y mecánica, y 3) almacenamiento de baterías (que también he mencionado antes cuando escribí sobre soluciones de energía renovable aquí)

Si los tres factores pueden avanzar juntos, la comercialización y el escalamiento masivo de la robótica humanoide probablemente se producirán en unos pocos años. Ahora, en el artículo de Unitree, hablo de China, dada su larga experiencia en la fabricación de hardware, que le ha dado una ventaja en conocimientos técnicos en mecatrónica, que combina tecnología mecánica y electrónica, dado que ha sido el centro de fabricación de hardware para varios electrodomésticos durante las últimas décadas. Si bien EE. UU. sigue siendo obviamente líder en GenAI, la pregunta es qué factor importa más, o ¿habrá una intención de colaboración? ¿Y quién puede descubrir la última pieza? Una mejor solución de baterías. ¿Pueden hacer baterías más livianas, duraderas y seguras?

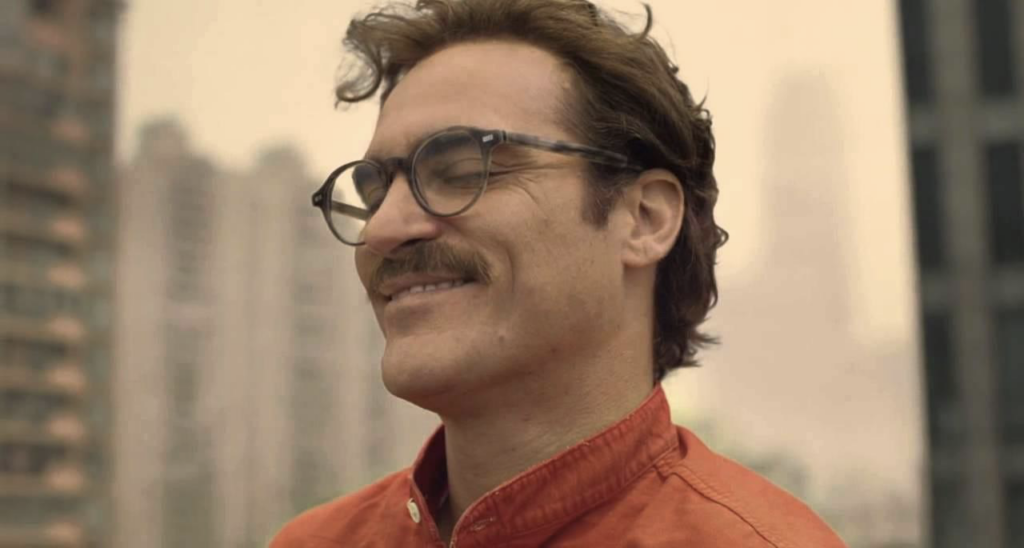

Los humanos llevamos décadas soñando con un mundo en el que los robots estén a nuestro lado, desde la película Her de 2013, en la que imaginamos una amante virtual con inteligencia artificial (que ahora prácticamente puede ser real), hasta el thriller de ciencia ficción de 2024 protagonizado por Megan Fox Subservience, en el que la inteligencia artificial física desafía nuestra moral de fidelidad y lealtad e incluso conduce a riesgos de seguridad perjudiciales. Siempre se ha imaginado que algún día tendremos seres robóticos. Es solo que ahora, la tecnología finalmente ha avanzado lo suficiente como para alcanzar nuestra imaginación (obviamente, los humanoides actuales no se parecen en nada a Megan Fox todavía).

Un robot que se enamora del humano y se vuelve malvado en la película /Subservience/

Protagonista humana que se enamora de un agente de voz de IA en la película /Her/

Así que, volviendo a lo que me he planteado, esto es obviamente sólo el principio. Como ahora todos los recursos se destinan a la IA física (o a la IA en general), este campo interdisciplinario madurará y seguirá avanzando más rápido de lo que tal vez podamos siquiera comprender. A medida que nuestros mundos físicos y digitales siguen moldeándose y mezclándose entre sí, las preocupaciones de seguridad realmente me preocupan como madre de una niña de dos años. Si los teléfonos inteligentes ya están confundiendo a los niños sobre la realidad, ¿cómo deberíamos regular esta tecnología y de qué serán capaces los robots cuando ella llegue a la adolescencia?

Aún queda mucho por desentrañar, por lo que agregaré una nueva vertical a AI Proem: IA física. En En esta vertical, exploraré las muchas áreas que pueden afectar el desarrollo de la IA física. Primero, profundizaré en la empresa líder de robots humanoides de China, Unitree Robotics, que a menudo se compara con Boston Dynamics. También exploraré el ángulo de la solución de baterías, que he estado tratando de encontrar tiempo para analizar después de Mi pieza sobre energía renovable.

Luego, creo que será interesante explorar las preocupaciones en torno a las posibles teorías sobre cómo los robots se volverán rebeldes. Esto se refiere a la seguridad general de la robótica y la destreza de las máquinas robóticas. Luego están los aspectos técnicos de la conectividad, el ancho de banda, las complicaciones de latencia y otros componentes clave: sensores (LIDAR), fusión de sensores y tecnología de arquitectura de software. Esto también está relacionado con otro trabajo en progreso que examinará cómo las empresas de vehículos eléctricos están haciendo la transición a empresas que priorizan la IA siguiendo los pasos de Tesla (Li Auto, por ejemplo).

También quiero ampliar mi cobertura para incluir cómo la IA afectará nuestro flujo de trabajo, por lo que estoy explorando cómo nuestra fuerza laboral se verá afectada por la adopción de IA física y potencialmente luego investigando un futuro software de IA o cómo la IA afectará nuestras plataformas de software más populares de la era de Internet.

¡Hay tanto que aprender y sobre lo que escribir! Por ahora, toodeloo~

Gracias por leer Proema de IA¡Suscríbete gratis para recibir nuevas publicaciones y apoyar mi trabajo!

Suscríbete para recibir actualizaciones de las últimas publicaciones del blog

Deja tu comentario: