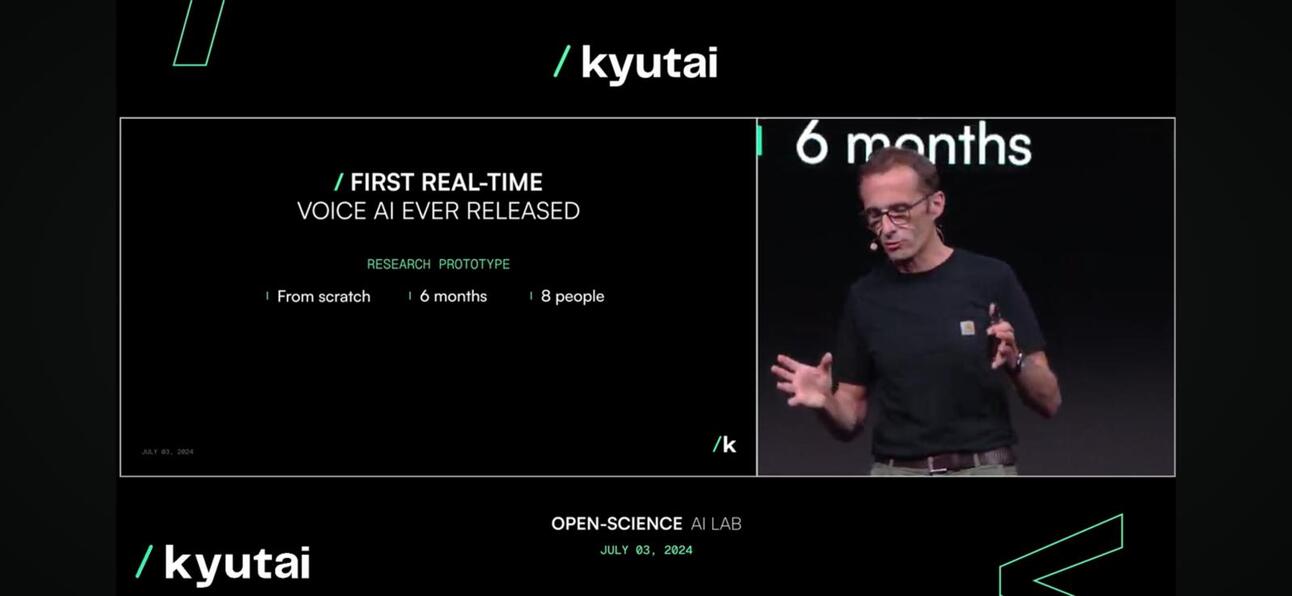

Kyutai presentó ayer Moshi, un modelo de base multimodal nativo de código abierto en tiempo real que puede escuchar y hablar, lo que provocó un gran revuelo en la presentación y en línea.

¿Por qué es tan emocionante?

Moshi es capaz de comprender y expresar emociones, con diferentes acentos para la entrada y la salida. También puede escuchar y generar audio y voz mientras mantiene un flujo de pensamientos textuales. Moshi también puede manejar dos transmisiones de audio a la vez, lo que le permite escuchar y hablar al mismo tiempo.

Mucho más cercano a un ser humano (o Skynet).

¿Qué tiene esto de novedoso?

- Calidad de la conversaciónEl tono de voz representa el 70% de las conversaciones de voz, por ejemplo, las llamadas telefónicas, mientras que las palabras representan el 30% restante. El equipo de Kyutai introdujo un modelo de lenguaje de audio que convierte el audio en “pseudopalabras” y predice el siguiente segmento de audio a partir del audio anterior para trasladarlo a una conversación natural y mejorar así el 70% de las conversaciones de voz.

- Latencia de conversaciónLa latencia máxima que podemos tolerar para tener una conversación natural es de alrededor de 150 milisegundos. Como primera versión, el modelo Moshi puede ofrecer una latencia de entre 160 ms y 200 ms. No es perfecto, pero teniendo en cuenta que GPT4o ronda los 150 milisegundos, es una latencia de entre 160 ms y 200 ms. 232 a 320 ms, Es bastante notable, especialmente considerando que son un equipo pequeño de 8 ETP.

Moshi, corriendo en tiempo real

Moshi, corriendo en tiempo real - Accesibilidad. El modelo puede ejecutarse en un dispositivo como un ordenador portátil o un teléfono móvil, lo que lo hace mucho más accesible para los consumidores.

Compresión del modelo para que esté disponible en el borde

Compresión del modelo para que esté disponible en el borde

¿Así que lo que?

- A un propietario de negocio o empresaLas interacciones con los clientes son el eje central de cualquier negocio. A medida que la mayoría de las empresas desarrollan su estrategia de IA, aprovechar un LLM para mejorar la experiencia del cliente a través del chat es una parte clave de la misma, aunque basada en texto. La siguiente fase de esta estrategia es mejorar la experiencia del cliente a nivel de voz, o lo que se conoce como un modelo multimodal, que está a la vuelta de la esquina.

- A una startup, envolver un LLM de código cerrado o de código abierto ya no es suficiente. ¿Cómo se integra un mensaje de voz en la aplicación? Perplexity está introduciendo una función de pago para mensajes de voz. Todavía no es genial, pero es tendencia.

- ¿Cómo afecta esto a Asia?? Asia, especialmente el sudeste asiático, es un mercado no homogéneo, y las diferencias de idioma y de diálogo local son desafíos clave para la expansión comercial. El modelo LLM y Voice es una excelente manera de resolver este desafío y ayudar a las personas y las empresas a navegar por la región. Los fabricantes de teléfonos, especialmente los chinos, están tomando medidas para abordar este desafío y esta oportunidad.

¿Cómo lo hicieron?

Kyutai desarrolló Helium, un modelo de lenguaje de 7 mil millones de parámetros, y entrenó previamente a Moshi con una combinación de texto sintético y datos de audio de dicho modelo de lenguaje. Profundizando un poco más, el ajuste fino de Moshi implicó 100.000 conversiones sintéticas convertidas con tecnología Text-to-Speech (TTS), y su voz fue entrenada con datos sintéticos generados por otro modelo TTS.

¿Qué sigue para Kyutai?

Podemos esperar un informe técnico y versiones del modelo abiertas; las iteraciones futuras se perfeccionarán en función de los comentarios de los usuarios con una estrategia de licencia súper liberal y permisiva para fomentar la adopción.

Para ver la conferencia completa, haga clic aquí.

Por último, tenga cuidado con el Este; Dubao El modelo de Bytedance, que tiene el contenido de video y audio más rico, será el jugador más formidable en este espacio.

Suscríbete para recibir actualizaciones de las últimas publicaciones del blog

Deja tu comentario: