Presentando las tomas de Leo

Como ex CDO de Huawei Cloud y habiendo creado uno de los ecosistemas de startups más grandes de la región, tuve acceso directo a:

- Organización y equipo que desarrollan chipsets de GPU, LLM (modelos de lenguaje grandes) y otros LM (modelos grandes);

- Empresas que se están embarcando en su viaje de transformación hacia la IA; y

- Empresas emergentes de inteligencia artificial tanto de Oriente como de Occidente que desarrollan herramientas y aplicaciones LLM y GenAI.

¿Qué relevancia tiene esto para usted?

- Si eres un ejecutivo de negocios o profesionalEste artículo le brindará una visión integral del panorama tecnológico actual de LLM y GenAI y conocimientos prácticos sobre los riesgos y oportunidades subyacentes.

- Si eres un fundador o inversorEste artículo le ayudará a comprender los obstáculos y las oportunidades reales en su búsqueda de IA.

Las opiniones de Leo que aparecen a continuación son mis opiniones, derivadas de una combinación de mi experiencia y un estudio de diligencia debida del mercado, que incluye talleres, entrevistas y debates con profesionales del sector relevante. Entre estos profesionales se incluyen analistas de investigación, desarrolladores, ejecutivos de empresas y fundadores, lo que garantiza una perspectiva completa y creíble.

La situación actual de GenAI y LLM

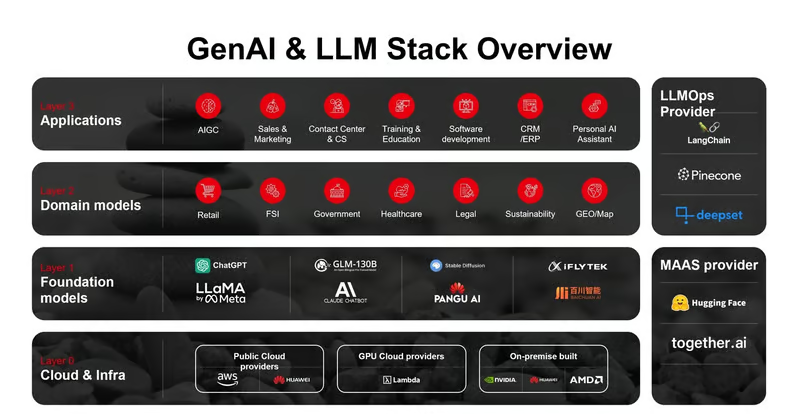

La pila tecnológica de GenAI y LLM se ha estabilizado, y cada una de las siguientes capas tiene su propio modelo de negocio, desafíos y oportunidades. Comprender estas capas es fundamental para navegar por el panorama de la IA y tomar decisiones comerciales informadas.

Capa 0 (nube e infraestructura): “donde está el dinero”

Esta capa es el metal desnudo que sustenta toda la pila GenAI. Representa un asombroso 80%+ del valor total de GenAI. economía. Aunque Nvidia seguramente domina, con casi el 95% del mercado de fabricantes de chips (Nvidia supera a Apple con una capitalización de mercado de 3 billones de dólares), el mercado está atrayendo a otros grandes, por ejemplo HuaweiJensen Huang identificó a Huawei como uno de los “formidables” rivales de NVIDIA, particularmente en el mercado de chips de IA. Mientras tanto, también atrae a empresas emergentes, innovadores, por ejemplo Grog, que se acercan al mercado con chips especialmente diseñados, LPU (unidad de procesamiento de lenguaje), que se centran en el rendimiento y la precisión de la inferencia de IA.

La opinión de Leo: La mayor ventaja que tiene Nvidia no son solo los potentes chipsets, sino también el ecosistema Cuda que ha creado a lo largo de los años. Ofrece a los desarrolladores lo siguiente:

- Diferentes idiomas y API;

- Biblioteca y marco para diferentes tareas de dominio;

- Herramientas para desarrolladores; y

- Socios del ecosistema

Aunque otras empresas como Huawei y AMD ofrecen productos similares, la usabilidad y la riqueza de sus ecosistemas se dan a diferentes escalas. Esto hace que los desarrolladores deban hacer un esfuerzo sustancialmente mayor para crear modelos que funcionen con el chip subyacente, lo que hace que el costo de migrar de Nvidia a otros fabricantes de chips sea un obstáculo significativo. Para una empresa que cotiza en bolsa como AMD, la decisión de centrarse en el desarrollo de ecosistemas es un desafío, ya que requiere una inversión a largo plazo y no generará retornos a corto o mediano plazo. Huawei, al ser una empresa no pública, tiene una ventaja en este aspecto, pero las sanciones estadounidenses también obstaculizan su progreso.

Capa 1 (modelos fundamentales y LLM): “¿Quién puede construir la bomba más grande?”

El motor de la pila GenAI que impulsa todas las aplicaciones GenAI que son impulsadas por aquellos que pueden desarrollar los modelos más capaces, y sucede a nivel internacional y nacional, especialmente en los EE. UU. y China.

- Carrera entre Anthropic y OpenAI – El modelo Claude 3.5 Sonnet supera a los modelos de la competencia; y

- La carrera entre los LLM de código cerrado y los LLM de código abierto y la brecha se cierra con un retraso de entre 6 y 10 meses.

Fuente: Linkedin

- La “Guerra de cientos de LLM en China”: la guerra de precios entre cientos de fabricantes de LLM en China es intensificandoBytedance ofreció su modelo a 10% del precio de mercado a fines de mayo de este año, seguido por los modelos de Alibaba Cloud y Baidu con precios similares.

Y estamos empezando a ver una “Guerra Fría de la IA” entre Occidente y Oriente.

- OpenAI planea bloquear el acceso a API en China a partir del 9 de julio, lo que ha llevado a los creadores de LLM chinos a ofrecer alternativas a decenas de miles de desarrolladores. China implementó Medidas Provisionales para la Administración del Servicio de Inteligencia Artificial Generativa en 2023, lo que elevó el nivel para el desarrollo de LLM extranjeros en China.

- Asamblea General de Naciones Unidas aprueba resolución liderada por China sobre inteligencia artificialEstá aprovechando el poder blando para defender el desarrollo de la IA en un entorno "libre, abierto, inclusivo y no discriminatorio", en respuesta a la creciente tensión entre Estados Unidos y China.

La opinión de Leo: La naturaleza de la competencia LLM no se limita a la tecnología, sino también al “ser inteligente” que está profundamente arraigado en la cultura y el idioma del país o la región. Por ejemplo, la inversión de Singapur de $70M SGD en su Programa Nacional Multimodal de Modelos Lingüísticos Grandes (LLM), conocido como Sea-lion, es un testimonio de este.

Técnicamente, el panorama de los LLM acabará convergiendo en un puñado de modelos, incluidos los de código abierto y los de código cerrado. El líder, como OpenAI, puede llevar una ventaja de entre seis y doce meses con respecto a los demás. Los modelos de código abierto están cerrando la brecha rápidamente, dado que la mayoría de las empresas prefieren tener la opción de modelos de código abierto, con el deseo de conservar el control y la privacidad. El resultado de la encuesta en el foro de inteligencia artificial de Economist Intelligence Network en el que hablé en Singapur el año pasado muestra que más del 70% de los directivos de nivel C están abiertos a los LLM de código abierto.

Fuente: AI Business Asia, Foro de inteligencia artificial de The Economist en Singapur, 2023

Las empresas ya no evalúan la “potencia” de los LLM; han estado acelerando su transformación GenAI con PoC rápidas desde principios de 2024, aunque sigue siendo la corriente principal para una PoC gratuita o con un presupuesto de entre $50K ~ $100K. Esto está creando una “tormenta perfecta” para las capas anteriores y la convergencia de nuevas capas.

Capas emergentes y capa de modelo de dominio: “El campo de batalla de las startups B2B”

El modelo como servicio (MaaS) es una capa híbrida de infraestructura y una capa de modelo fundamental. Ofrece a las empresas un acceso fácil al poder de los LLM con modelos entrenados previamente y reduce los costos de capital humano. La capa de operaciones de LLM es la capa de herramientas que ayuda a las empresas a optimizar el proceso de desarrollo de aplicaciones y a crear modelos específicos del dominio. Los modelos específicos del dominio están entrenados (ajustados) para un propósito específico de una industria o tarea.

La opinión de Leo: Este es el campo de batalla de las empresas emergentes B2B, que colectivamente intentan resolver un problema: ¿cómo crear aplicaciones GenAI con una eficiencia óptima?

El proceso de desarrollo y operación de una aplicación GenAI es complejo y ha atraído a miles de nuevas empresas B2B que se sumarán a este espacio en 2024, todas ellas creyentes en la idea de "vender palas durante la fiebre del oro". A muchas de ellas les está yendo bien, por ejemplo, Langchain, Flowiseai. Sin embargo, las capas emergentes son espacios volátiles, principalmente debido al ritmo de desarrollo de la capa del modelo fundacional (LLM). Los límites y las características de los LLM están evolucionando, lo que hizo que la versión anterior de LLM quedara obsoleta; por ejemplo, GPT3.5 se está depreciando y se están agregando nuevas características y capacidades que pueden superponerse con algunas de estas herramientas.

Los proveedores de servicios en la nube están entrando en el espacio de MaaS, que ofrece modelos de código abierto previamente entrenados como una API; al final, es una competencia de tokens por segundo y costos asociados. Dicho esto, los actores como Huggingface, que crearon sus modelos y seleccionaron una gran comunidad de desarrolladores, siguen prosperando; por ejemplo, se estima que Huggingface generó $70M ARR el año pasado. Estoy de acuerdo con esto, pero creo que estos ingresos se atribuyen en gran medida a su socio AWS en lugar de a los desarrolladores en función de la participación en los ingresos por inferencia de IA.

¿Cuál es la moraleja de todo esto? De las cinco capas, este es mi espacio favorito y tengo un inmenso respeto por los creadores y fundadores de este espacio. Son ellos quienes crean los "múltiples" que ayudan a que todo el ecosistema produzca mejores resultados y valor. Mientras tanto, el riesgo es bastante alto para las empresas emergentes y los inversores, pero también lo es la recompensa.

Así que, independientemente de si eres fundador o inversor, creo que los tres factores clave del éxito (sigue esta secuencia) son:

- La audiencia primero;

- El problema viene en segundo lugar; y

- Por fin, su producto.

Es importante tener en cuenta que tu audiencia no es necesariamente tu cliente. En muchos casos, es posible que primero debas hacer crecer tu comunidad de audiencia y generar ingresos a partir de otras fuentes, como se vio en el caso de Huggingface.

Capa 3 (Aplicaciones GenAI): “La necesidad de velocidad”

Esta es la capa más despiadada de todas, impulsada principalmente por las aplicaciones y herramientas GenAI B2C. a16z publicó los 50 mejores productos web GenAI; según las visitas mensuales, muestra que más del 40 por ciento de las empresas de la lista son nuevas, en comparación con nuestro informe inicial de septiembre de 2023. Este tipo de facturación influye en la capacidad y la velocidad de la empresa para completar el ajuste producto-mercado (PMF). Esto empuja a la mayoría de estas empresas B2C a envolverse en algunas LLM conocidas, como GPT4 y Llama3, que los inversores suelen criticar por ser una empresa envolvente.

Fuente: a16z

La opinión de Leo: No hay nada de malo en ser una empresa que solo vende productos, ya que el producto final que deleita al cliente es el que más importa. A medida que los LLM subyacentes se conviertan en un producto básico, la forma en que organice la IA (por ejemplo, la latencia, la integración del flujo de trabajo y la interfaz de usuario) será lo más importante. En ese sentido, la agencia humana es lo más importante del producto.

He entrevistado a más de 100 startups de IA, desde la etapa inicial hasta la etapa unicornio, entre Occidente (por ejemplo, EE. UU. y la UE) y Oriente (por ejemplo, China y Singapur) desde 2023. Las dos partes muestran enfoques muy diferentes para llegar al mercado: las startups estadounidenses están muy centradas en el producto, mientras que las startups chinas son mucho más flexibles con el servicio. La razón principal es que el mercado asiático exige más personalización. Este es uno de los factores de agencia humana que importa para el éxito de las empresas de aplicaciones. Con eso, no me refiero a crear una aplicación que sea tan personalizable que se pueda escalar, sino a la capacidad de desarrollar rápidamente una aplicación con características específicas y dirigida a un espacio o audiencia de nicho. China ya no es la fábrica mundial que conoces, que fabrica los productos de consumo que usas a diario. Ahora se está preparando para ser la fábrica mundial de aplicaciones de IA, especialmente dada la proliferación de aplicaciones GenAI.

Mira mi publicación, “Un cambio de paradigma en la creación de una startup de un millón de dólares en menos de un año si se adopta el enfoque correcto.”

¿Cuál es la fuente secreta detrás de su éxito?

Impacto en las empresas emergentes y de nueva creación de Asia

La evaluación de LLM y GenAI es, con diferencia, la progresión tecnológica de ritmo más rápido en la historia de la humanidad, y no se está desacelerando, sino que se está acelerando. Los mayores desafíos entre los directivos y los fundadores no son elegir los modelos y las aplicaciones, sino abordar las brechas de conocimiento cada vez mayores y desarrollar una estrategia y una ejecución para garantizar que la IA funcione para ellos.

Asia es un mercado con un gran potencial y desafíos, ya que es el continente más poblado y no es homogéneo. Sin embargo, a menudo recibe menos atención de los creadores de IA en los EE. UU. Por ejemplo, OpenAI abrió su primera oficina en Tokio este año, y la mayoría de las empresas emergentes de IA de los EE. UU. con las que he hablado se centran exclusivamente en los EE. UU. y la UE. Huggingface, por ejemplo, tiene solo un par de empleados en Asia. Esta situación presenta tanto un problema como una oportunidad para los fundadores y las empresas de Asia, y es fundamental estar al tanto de estas dinámicas.

Suscríbete para recibir actualizaciones de las últimas publicaciones del blog

Deja tu comentario: